ADVERTISEMENT

人們希望自動駕駛汽車能夠像人一樣思考,或像AI一樣思考,因為電腦的能力比人腦更強;同時還希望像人一樣能感知,對於外界的刺激和感官訊息有系統的解讀,進而能夠像人一樣開車。這個要求目前看起來有點太高了,如果真能做到,自動駕駛也不會是,現在的樣子。

早在2019年,特斯拉就在「自動駕駛投資者日」上說,透過觀測人類駕駛在各種路況所選擇的路徑和典型人類行動,來創建帶有人類標記的圖像來訓練網路。特斯拉希望利用感知系統超越環境模仿人類大腦智慧感知能力,利用人工智慧(AI)讓自動駕駛汽車像機器人一樣思考,就像人類數以百萬計的神經元組成的神經網路那樣。

結果呢?直到2021年,對大貨車視而不見車毀人亡的場面還是屢見不鮮,且不僅是特斯拉。

另一種聲音是,像人一樣思考,不如像人一樣感知,而且已經有了這樣的感知技術。

人腦的啟示

三十多年來,史丹佛大學醫學院神經外科系的臨床教授和醫學博士James Doty一直在研究和實施人腦手術。「我一直著迷於大腦的力量、可塑性和適應性,以及它驚人的能力中有多少用於處理和解釋我們從感官接收到的資料。」他說。

Doty還是史丹佛大學同情和利他主義研究與教育中心的創始人和主任。他與來自多個學科的科學家合作,研究人的神經基礎。他擁有多項專利,曾是射波刀技術(Cyber knife:又稱「立體定位射波手術平台」)的發明者Accuray的前首席執行長;也是《走進魔法商店:神經外科醫生探索大腦奧秘和心臟奧秘》的紐約時報暢銷書作者。

他認為,自動駕駛汽車的未來是除了是像機器人一樣思考,更要像人一樣感知。

他指出,隨著AI的迅速崛起,開發人員需要整合複雜、多層次的人類感知來增強AI能力。問題在於,這種整合的應用如何滿足整個自主統一體的要求,包括從ADAS到移動性,以及卡車運輸、交通、建築、鐵路、智慧型交通系統(ITS)、航太和國防領域的自動化應用。

「很明顯,對我來說,驅動這些應用所需的AI需要模仿地球上最偉大的感知引擎——人類視覺皮層。這些交通工具需要像機器人一樣思考,但先要像人一樣感知。」

為了瞭解更多資訊,更好地理解這種人工感知水準如何產生,他成為了AEye的顧問。AEye是一家開發尖端人工感知和自動駕駛技術的公司,幫助他們利用人腦知識更好地為系統提供資訊。這就是仿生:從生物系統(植物、動物、人類等)學習和複製自然的策略,以創造更靈敏、更智慧化的技術和產品。從本質上說,仿生學使人們能夠適應現有環境,並以數十億年來生命成功的方式進化。

為什麼將仿生學和人類感知的各個方面納入自動駕駛汽車的開發之中呢?

Doty解釋,因為沒有什麼能比人類的視覺皮層接收更多的資訊,並且能更快更準確地處理。人類以高達27Hz的速度對複雜物體進行分類,大腦在13毫秒內處理5.8億像素資料。他告誡說:「如果我們繼續使用傳統的感測器數據收集方法,我們距離自動駕駛車輛中AI實現人腦功能還有25年多的時間。因此,為了使自動駕駛汽車能夠在擁擠的城市環境中或以高速公路速度安全地獨立行駛,我們必須開發新的方法和技術,以達到或超過人腦的性能。」

人腦如果像現在自動駕駛運作,人類早就滅絕了

下一個問題是:如何做?並非所有物體都生來一樣,人能夠看到一切,卻只關注重要的事情。人類不斷地分析所處的環境,不斷「掃描」新的物體,然後並行地(並視情況而定)關注有趣或潛在威脅的元素。人的視覺皮層處理速度非常快,準確度令人難以置信,幾乎用不到大腦巨大的處理能力。「如果人類的大腦像今天的自動駕駛汽車一樣工作,我們就不會作為一個物種存活下來。」Doty說。

Bob Nease在《決策的力量》(The Power of Five Bits)一書中描述人類大腦每秒處理一千兆bit的資訊,但只有50 bit用於有意識思維。這是由多種進化因素造成的,包括我們對忽略心臟跳動等自主過程的適應,或者由視覺皮層篩選出與生存無關的環境資訊。

這就是我們智慧願景的本質。雖然我們的眼睛總是在掃描和搜尋,以辨識進入場景的新物件,但我們將注意力集中在重要物件上,因為它們移動到受關注的區域,使我們能夠做出適當的回應。簡言之,我們搜尋場景,有意識地獲取重要物件,並根據需要對其採取行動。

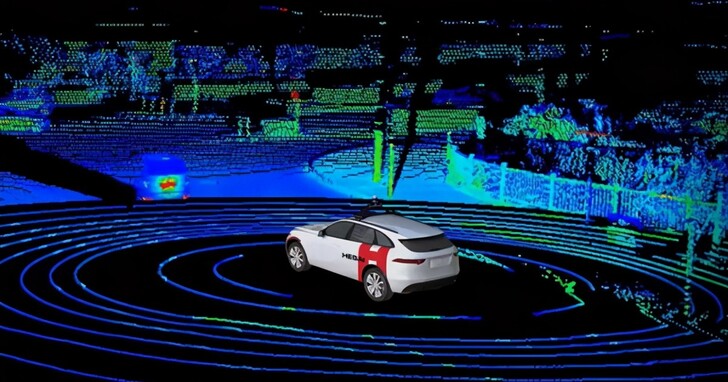

當前的自主車輛感測器配置利用光達、攝影鏡頭、超音波和雷達的組合作為其「感官」,限於固定搜尋模式連續(單向)收集資訊。這些「感官」收集盡可能多的資料,然後在事件發生很久之後進行校準、處理和分析。這種後處理速度很慢,無法實現即時捕獲感官資料方式的變化。因為這些感測器不會智慧地發出詢問,所以收集到的90%感官資料在處理時會被丟棄,因為這些資料要嘛無關,要嘛多餘。這種分類行為也會帶來延遲懲罰。在高速公路上的行駛速度,這種延遲會導致車輛在感測器資料完全處理之前移動超過6公尺。為了提高效率而丟棄不需要的資料效率很低。

對每棵樹、路緣、停放的車輛、道路和其他靜態物件進行資料篩選的艱巨任務也需要巨大的電力和資料處理資源(算力),雖然功率隨著算力不斷攀升,整個系統的速度並沒有多大起色,並帶來了風險。這些系統的目標是關注一切,然後在事後嘗試分析環境中的每一項,而犧牲及時的行動。這與人類在與駕駛相關的情況下處理時空資料的方式完全相反。

人是直覺學習動物

如前所述,人類視覺皮層的掃描頻率為27Hz,而自動駕駛感測器平均為10Hz左右。大腦自然地從視覺皮層收集資訊,形成回饋迴路,説明提高感知過程每一步的效率。然後,大腦引導眼睛搜尋並聚焦於某些物體,辨識它們並確定其優先順序,並決定最有效的行動方案,同時在很大程度上忽略其他不太重要的物體。這種優先順序允許更高的效率並增加時間和空間採樣,不僅掃描更智慧,而且效果更好。

你試試看,環顧四周,發現有許多深度、顏色、陰影和其他資訊需要用眼睛捕捉,然後是運動。再考慮一下你的經驗:某個物體能夠運動還是可能保持靜止?它的行為是可預測還是不穩定的?你覺得這個物體有價值嗎?還是認為它沒什麼用?雖然你沒有意識到這些結果,但大腦是這樣做的。

自動或半自動車輛當前的感測器系統針對「搜尋」進行了最佳化,然後將「搜尋」報告給中央處理器。搜尋是通過單個被動感測器完成的,無論環境如何變化,這些感測器在任何時候都會在任何地方使用相同功率、強度和搜尋模式。

局限性在於:資料只從被動感測器單向流向中央處理器,無法主動適應或調整其採集。所有智慧化都是在融合和毀滅之後加入的,當即時學習和調整為時已晚時,高達95%的智能會被丟棄。

智慧型探測和感知

Blair LaCorte是AEye首席執行長,也是積極訓練同盟(Positive Coaching Alliance)董事會成員,曾榮獲美國太空總署頒發的「年度創新者」和《行業週刊》的「年度產品」獎。

在他的公司,智慧型光達感測器系統iDAR™(智慧探測和測距)是一種創新的高性能固態主動光達,使自動駕駛車輛能夠像人類一樣「搜尋、獲取和行動」。它透過定義新的資料和感測器類型來做到這一點,這些資料和感測器類型可以更有效地傳達可操作的資訊,同時具有快速準確地分析這些資料的智慧。

LaCorte介紹說,iDAR平台分為四個簡單層次,每層都是為了滿足各種出行要求,如ADAS、交通運輸、建築、鐵路、ITS、航太等領域特定用例或應用。四個層次是:設計性iDAR、觸發性iDAR、回應性iDAR和預測性iDAR。

設計性iDAR:允許創建單一的確定性掃描模式,為特殊用例提供最佳資訊

觸發性iDAR:透過外部輸入(如地圖、速度和天氣)觸發確定性模式庫

回應性iDAR:能夠感知場景,即時調整場景掃描方式,使用不同密度和額外功率。

回應性iDAR平台由回饋迴路和其他感測器(如攝影鏡頭和雷達)通知光達聚焦於特定興趣點。系統智慧化能夠主動理解和詢問場景,並不斷最佳化自身掃描模式和資料收集,以關注最重要的資訊,類似於人類感知。

因此,與標準光達不同,AEye的主動光達具有情境適應性,可以修改掃描模式和資源,如功率、更新率、解析度、重現和範圍。這使得iDAR能夠動態利用感測器資源,以最佳方式搜尋場景,有效辨識和獲取關鍵物件,例如道路上的兒童或進入十字路口的汽車,並確定適當的行動方案。即時執行此操作對安全出行、避免悲劇至關重要。

iDAR被認為是唯一一個用於ADAS、移動性等的人工感知平台,它是真正的軟體可配置的,能夠實現智慧和主動感知。透過使用主動光達在感測器等級根據客戶或應用自訂資料收集,並提供大量可調整和自訂的配置設置,智慧型收集資料,以滿足自主應用需求。iDAR可以適應新的技術和演算法,不斷最佳化成本和性能。

像人類一樣動態感知

iDAR是一個活躍的多維系統,它依靠回饋迴路高效地迴圈資訊,以適當地即時修改反應,就像人類一樣。攝影鏡頭可以與光達通訊,同時感測器系統可以與路徑規劃系統即時通訊。

除了提高回應時間,回饋迴路還使人工智慧能夠更有效地與人工感知相結合。現在的感測器系統無論在什麼情況下都會被動地回饋相同類型的資料。iDAR將感官資料捕獲和處理推送到感測器,而不是集中到處理器,支援更快的整合回饋迴圈來通知和隊列操作。透過這種方式,iDAR系統能夠持續學習,以便隨時間推移更有效地辨識和跟蹤可能威脅自動駕駛車輛、乘客、其他駕駛和行人安全的物件和情況。

這就是前面所說的預測性iDAR。像人類一樣,它能夠理解所看到的一切運動,這使得系統能夠用更少的資料傳遞更多的資訊,將其能量集中在場景中最重要的物件,同時關注周圍的一切。其最終結果是透過神經網路進行運動預測。與人類的直覺一樣,可以「感知」(預測)未來不同時間物體的位置,説明車輛評估碰撞風險並確定安全路線。

當涉及到運動物體感知時,通常需要兩種類型的關鍵正交資料集:空間和時間。空間資料確定物件在世界上的位置,而時間資料確定物件在時間上的位置。透過將這些資料集與其他資料集(如顏色、溫度、聲音和氣味)整合在一起,我們的大腦就可以生成周圍世界的即時模型,定義我們的體驗方式。

人類大腦自然地接收各種正交資料,在我們沒有意識到的情況下,即時分離和重組資訊。例如,如果你看到一個棒球向你飛來,你的大腦就會收集關於它的各種資訊,比如空間(球的方向)和時間(球移動的速度)。當你的視覺皮層在「背景」中處理這些資料時,你最終意識到的是你需要採取的行動,可能是躲避。

LaCorte認為,能夠成功採用人腦捕獲和處理這些類型資料集的方式的AI感知技術將主宰市場。而現有的機器人感測器系統只專注於單感測器模式(攝影鏡頭、光達或雷達),且只具有固定的掃描模式和強度。與人類不同,這些系統沒有當感測器檢測到物體運動時即時有效地處理和最佳化2D和3D資料的學習能力。簡單地說,它們不能使用即時正交資料來學習、排序和聚焦。因此,有效地複製人類視覺皮層的多維感官處理能力需要一種新的方法來思考如何捕獲和處理感官資料。

所謂正交資料指的是互補資料集,最終為我們提供有關某個物件或情況,比單獨提供的資訊更多。這使我們能夠確定所處世界中什麼是重要的,什麼不是。高資訊品質的正交性概念已被很好地理解,並植根於量子物理等學科,在這些學科中,使用線性代數,用正交基集(basis set)表示更複雜狀態而不需要多餘的最小資訊片段。

AEye的智慧感應方法能夠捕捉「多種感官」,並對車輛周圍環境有更廣泛的瞭解。透過固態主動光達與高解析度攝影鏡頭的實體融合,AEye創建了一種稱為動態Vixel(體素)的新資料類型,該資料類型可捕獲攝影鏡頭像素和3D光達體素。捕獲RGB和XYZ資料使車輛能夠像人類一樣(如果不比人類更好的話)實現視覺化。顏色不僅主導著駕駛基礎設施(如標誌或紅綠燈),也是視覺皮層的主要驅動因素之一。創造出動態體素就可以仿生人類視覺皮層的資料結構。

與人類視覺皮層一樣,動態體素中固有的智慧隨後被整合到中央感知引擎和運動規劃系統(即車輛的功能大腦)中。它們是動態的,因為它們能夠根據不斷變化的條件進行調整,例如增加感測器的功率水準以穿透雨水,或者在同一個影格中重新檢查可疑物體以辨識障礙物。更好的資料驅動可以獲得更多可操作的資訊。

需要超乎想像

如果像機器人一樣思考,像人類一樣感知,就可以從邏輯上減少人類的弱點,如攻擊性行為、疲勞、分心或酗酒風險;有可能達到並超越人類視覺皮層和大腦的能力,實現有史以來最強大的感知引擎。這樣我們就將節省時間、金錢、減輕壓力並提高安全性。

仿生學告訴我們,對於自動駕駛車輛,人工感知應該在感測器上進行更多的處理,以便有效地發揮作用。據稱,AEye的iDAR感測器系統是唯一能夠成功處理行業最具挑戰性極端情況的感測器,同時實現了超過200Hz(6倍人類視覺)的掃描速度,探測範圍為1公里(當前光達的3-5倍),而這已經VSI Labs測試:在超過1公里距離能夠檢測到目標更多的點數。

- 本文授權轉載自Techsugar

請注意!留言要自負法律責任,相關案例層出不窮,請慎重發文!