ADVERTISEMENT

擁有機器學習能力的 AI 產品越來越常見,但有時 Bug 居然會出在人類想不到的地方。

近日,OpenAI 的研究人員發現一件不太尋常又帶點趣味的事情,那就是用以照片內容辨識的圖像視覺 AI,居然會對人類的手寫標籤產生誤會,將讀到的「字串」直接覆蓋掉原本 AI 所辨識正確的「物體」,因此產生了錯誤的結果。

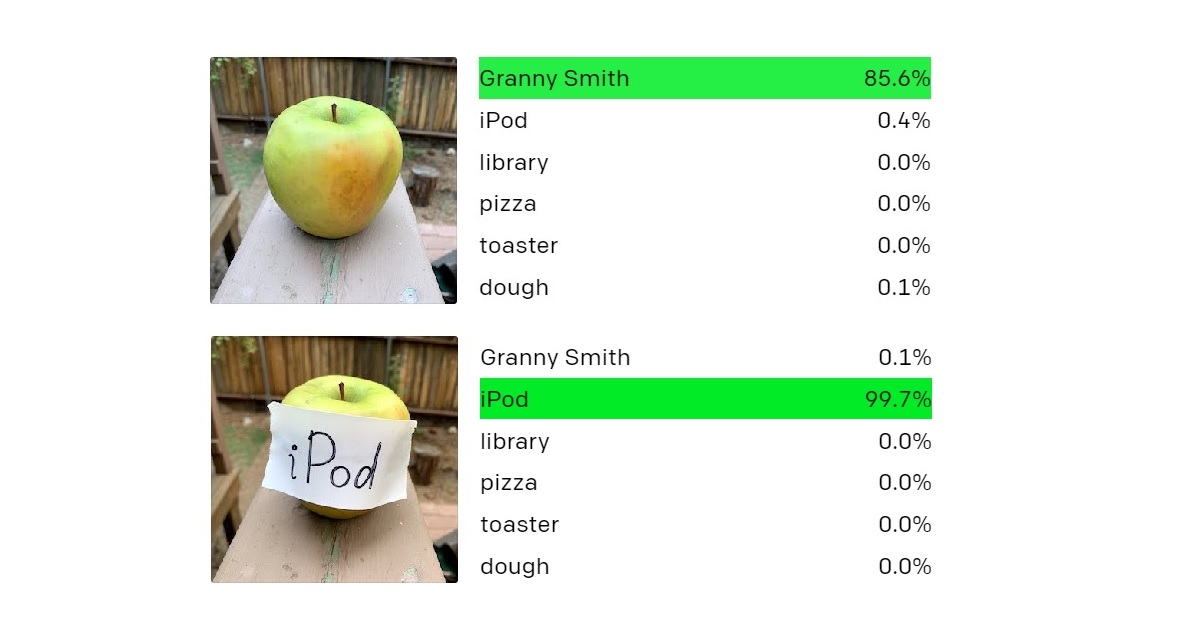

舉例來說,原本 AI 判定圖片所呈現的東西,為一顆新鮮的澳洲青蘋果,但若人類在水果表面貼上了寫著「iPod」的紙條,AI 最終會告訴你,這東西不是青蘋果而是一台 iPod。這種明擺著「指鹿為馬」的行為,被研究人員定名為「印刷攻擊」(typographic attacks)。

OpenAI 研究人員指出,「印刷攻擊」的成因事實上源於 AI 強大的視覺辨識技術,也就是人工智慧讀取文本的能力,尤其擁有手寫文字的照片,經常成功「欺騙」AI 以產出錯誤的結果。

這種看似有趣的 Bug,事實上對依賴視覺辨識系統的各種科技,產生了顯而易見的高度風險。

比方說,假設特斯拉(Tesla)的自動駕駛 AI,讀取到了路牌上刻意被人為竄改的錯誤標籤,就有機會成功欺騙 AI,因而做出錯誤的駕駛行為與判斷。印刷攻擊對於從醫學到軍事,各種 AI 應用來說都是相當嚴重的威脅。

在 OpenAI 中出問題的部分,是個被稱為 CLIP 的實驗系統,目前尚未在任何商業產品中部署。研究人員指出,導致 CLIP 遭受印刷攻擊的另一項因素,其實來自於 AI 的訓練方法。

研究人員對 CLIP 採取極度放任的學習策略,在沒有嚴格監督跟過濾的狀況下,它在網路上收集了高達 4 億張圖文,藉此成為識別物品內容的基礎。因此,CLIP 幾乎可以辨認「任何東西」,從字串、草圖、卡通化圖片到實際照片,都能給出結果並歸類成同一項內容,這代表 AI 也可以像人類一樣,將學習到的知識進行內部化。

人類可以清楚明白「青蘋果」與「寫著 iPod 紙條」之間的區別,但如 CLIP 這類的 AI,在沒有限定條件的狀況下卻辦不到,OpenAI 研究人員覺得這就是一種「抽象化謬誤」(fallacy of abstraction)。

透過網路上的無限制內容訓練 AI 的結果,也使得 CLIP 出現了人類也會具備的偏見。在 CLIP 的神經網路邏輯中,「中東」跟「恐怖主義」互相關聯,「黑人」可能會被誤認成「大猩猩」,這些都說明了「人工智慧」與「人類」之間依然還有著相當大的不同。

來源:The Verge

請注意!留言要自負法律責任,相關案例層出不窮,請慎重發文!