ADVERTISEMENT

MediaPipe是款由Google推出的開源機器學習管線框架,可以用來處理影像、聲音等時間序列資訊(Time Series Data),而最新整合進來的手部姿態辨識功能,提供了快速且精確的辨識品質,甚至能夠進行即時辨識,大大提升了應用的可能性。

解決手勢辨識難題

感應手部姿態或是手勢在各領域應用的使用者體驗占了重要的一席之地,由於手勢可以用於傳達資訊,同時也是手勢控制的基礎,並且也在AR應用中扮演了搓合現實與虛擬世界的媒介。

雖然擺出各種不同的手勢對人們來說是很自然的事,我們也能很直覺地分辨各種手勢並瞭解其意義,但是對於電腦或人工智慧系統來說,精準且即時的手勢辨識仍是個充滿挑戰性的影像辨識任務,再加上手部常常會被自己或另一支手遮擋,且不同手勢間的差異往往不大,因為讓辨識更加困難。

Google最新推出的手勢辨識感知技術,可以透過機器學習從單一畫格推算出21個手部的關鍵3D定位點,以提供準確的手部及手指姿態追蹤資料,而且更厲害的是它不需要像目前先進的感知技術需要依賴效能強大的電腦負責運算,只需輕量的運算設備就能滿足辨識的需求,不但能在智慧型手機上達到即時辨識的成果,甚至能同時辨識多支手的手勢,有助於將技術推廣至一般使用者,並激勵研究和開發社群創造各種利用實例。

從2D圖像推算3D位置

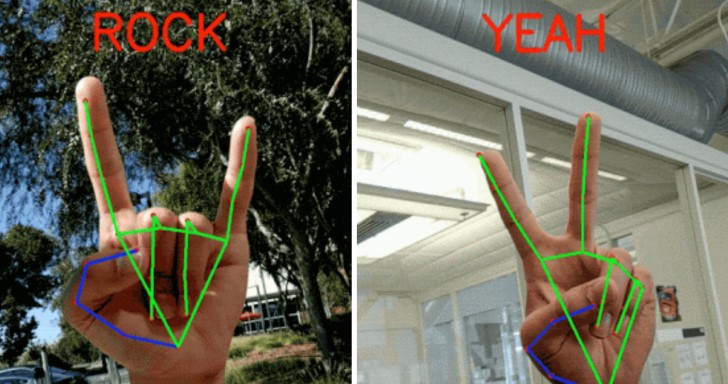

在辨識的過程中,系統會先使用稱為BlazePalm的手掌偵測模型從圖像中鎖定手掌的區域,接著使用手部區域辨識模型在鎖定區域中標記關鍵3D定位點,最後則是使用手勢辨識系統判讀定位點,根據關節的角度判斷每根指頭是伸直或彎曲,並對照事先參考多國文化建立的手勢資料庫,輸出辨識結果。

有趣的是,系統可以從2D平面的圖像,推算出21個手部關鍵3D定位點在立體空間中的位置,也就是說這些定位點除了有X、Y軸的座標資訊外,也有Z軸座標。而且為了提高演算法的準確度,研發團隊在訓練模型的過程中,除了以實際拍攝手部的影片外,還運用3D繪圖的動畫(如此一來可以完全掌握定位點的座標,並比對演算法是否判斷正確),讓模型能更精準標記定位點。

研發團對表示他們希望在未來的時間中,提升系統的可靠度與追蹤手部影像的穩定性,同時也在資料庫加入更多手勢,同時也邀請所有開發者發揮創意,將這套開源的系統實作於更多應用情境。

請注意!留言要自負法律責任,相關案例層出不窮,請慎重發文!