ADVERTISEMENT

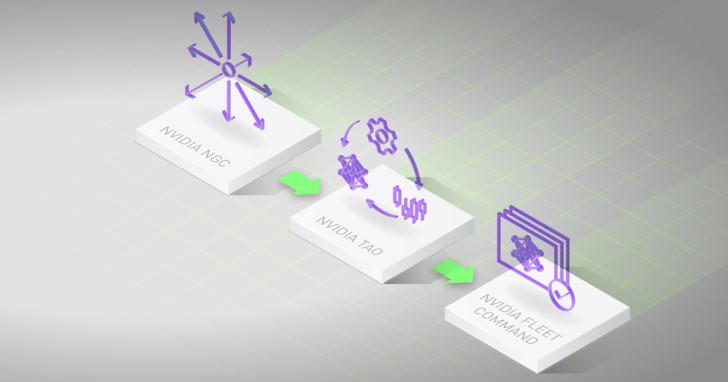

為了進一步強化企業導入AI的速度,NVIDIA透過NGC目錄提供預先訓練AI模型,並在GTC21發表Tao與Fleet Command等模型再訓練與部署套件,強化邊緣AI應用。

解決訓練AI模型之苦

NVIDIA除了供應AI運算所需的硬體平台外,也提供許多AI應用程式,舉例來說包含

- DLSS:深度學習超高取樣,能夠在將低效能需求同時提升遊戲畫質

- StyleGAN:人工智慧高解析度影像生成器

- GANcraft:神經渲染引擎(能將《Minecraft》遊戲畫面轉換為寫實的3D圖像)

- GANverse3D:能將照片轉換為可繪製動畫的3D模型

- Sim2Real:透過Omniverse創造https://www.techbang.com/posts/85860的數位孿生訓練的四足機器人

- Face Vid2Vid:頭部特寫的渲染引擎,能將串流的頻寬降低10倍,同時重新繪製頭部與眼睛的位置

- BioMegatron:有史以來訓練過最大型的生物醫學語言模型

- 3DGT:Omniverse 3D模型資料生成

- SimNet:以物理知識為基礎的神經網路求解器,能夠模擬大規模多重物理效果

- OrbNet:用於量子化學的機器學習量子求解器

不過對於使用者或企業而言,在備妥AI相關的軟、硬體之後,工作才剛剛開始,接下來還需要準備龐大的資料集,並花費大量時間進行AI模型的訓練。

為了縮短導入AI的流程,NVIDIA透過NGC目錄提供超過100種預先訓練的模型,種類包含語言建模、翻譯、自動語音辨識、文字轉語音、推薦系統、影像分割、物體偵測等不同應用領域,使用者可以直接將軟體或容器部署至本機、雲端或邊緣的電腦、伺服器、Kubernetes、虛擬電腦等裝置運作。

不過就算有了預先訓練模型,也可能會遇到訓練使用的資料集跟使用現場的情況有所落差,所以導致AI推論準確度不如預期的狀況。然而許多資料集因為商業或機密考量而無法與所有使用者分享,造成修正模型的阻礙。

透過少量資料重新訓練預先訓練模型

為了解決這個問題,NVIDIA推出Tao框架,讓使用者能夠透過輸入少量資料(可能少至100組資料),重新訓練預先訓練模型,強化AI推論準確度,將過去需要花費數日甚至數週的模型調整時間縮短至數小時,能讓多方研究人員訓練共享的模型,又同時確保資料隱私。

另一方面,Tao也能透過剪枝(Pruning)與量化(Quantization)等最佳化方式在不影響準確度的前提下,降低運算複雜度與模型尺寸,節省占用的運算資源並提升效能表現。

當使用者更新模型之後,可以透過一站式的Fleet Command管理套件快速更新並部署,節省將資料部署至邊緣節點所需的時間與人力。

本文刊登時GTC21目前還在持續進行中,更多資訊可以參考開幕演說重點整理一文,或參考本文免費註冊並參加線上會議以及超過1,300場主題演說。

請注意!留言要自負法律責任,相關案例層出不窮,請慎重發文!