ADVERTISEMENT

ChatGPT已經是大模型的天花板了嗎?不!沒有做不到,只有想不到。Google出手,果然不會讓人失望!

Google悄悄上線了一個炸彈級模型——足足有5620億參數!

PaLM-E 將真實世界的感測器訊號與文本輸入相結合,建立語言和感知的連結。

規模最大的模型「PaLM-E-562B」具有562B個參數,將540B的PaLM和22B的ViT整合在一起,這是目前報導的最大的視覺-語言模型。

模型輸入包括視覺、連續狀態估計值和文本輸入。作者在多個任務(包括順序機器人操作規劃、視覺問答和產生字幕)中進行了端到端的訓練,並透過評估表明,其模型能夠有效地解決各種推理任務,並且在不同的觀察模態和多個實體上表現出了積極的轉移。該模型在進行機器人任務訓練的同時,還具有先進的視覺-語言任務表現,並隨著規模的增大保持了通用的語言能力。

PaLM-E 是什麼

PaLM-E是一個單一通用的多模態語言模型,可用於感知推理任務、視覺語言任務和語言任務。它將來自視覺語言領域的知識轉化為體驗推理的知識,從具有複雜動態和物理約束的環境中進行機器人規劃,到回答關於可觀察世界的問題,都可輕鬆搞定!

它支援多模態輸入,來自任意模態(例如圖像、3D表示或狀態,綠色和藍色)的輸入插入文本token(橙色)旁邊作為LLM的輸入,進行端到端的訓練。

PaLM-E的主要架構思想:將連續的、可感知的觀察資料注入預先訓練的語言模型的嵌入空間中,以使其能夠理解這些連續資料。這是透過將連續觀測資料編碼為與語言嵌入空間中的語言標記具有相同維度的向量序列來實現的。這種連續資訊以類似於語言標記的方式注入語言模型中。

PaLM-E是一個僅具有解碼器的語言模型,可以自動地根據首碼或提示生成文本完成結果。該模型使用預先訓練的語言模型PaLM,並將其賦予感知推理的能力。

模型在真實世界裡的表現如何呢?

我們展示了幾個示範影片,展示了如何使用PaLM-E在兩個不同的真實實體上規劃和執行長期任務。請注意,所有這些結果都是使用同一模型在所有資料上訓練得出的。在第一個影片中,我們執行了一個長期指令「從抽屜裡拿來洋芋片」,其中包括多個規劃步驟,以及整合了機器人攝影鏡頭的視覺回饋。

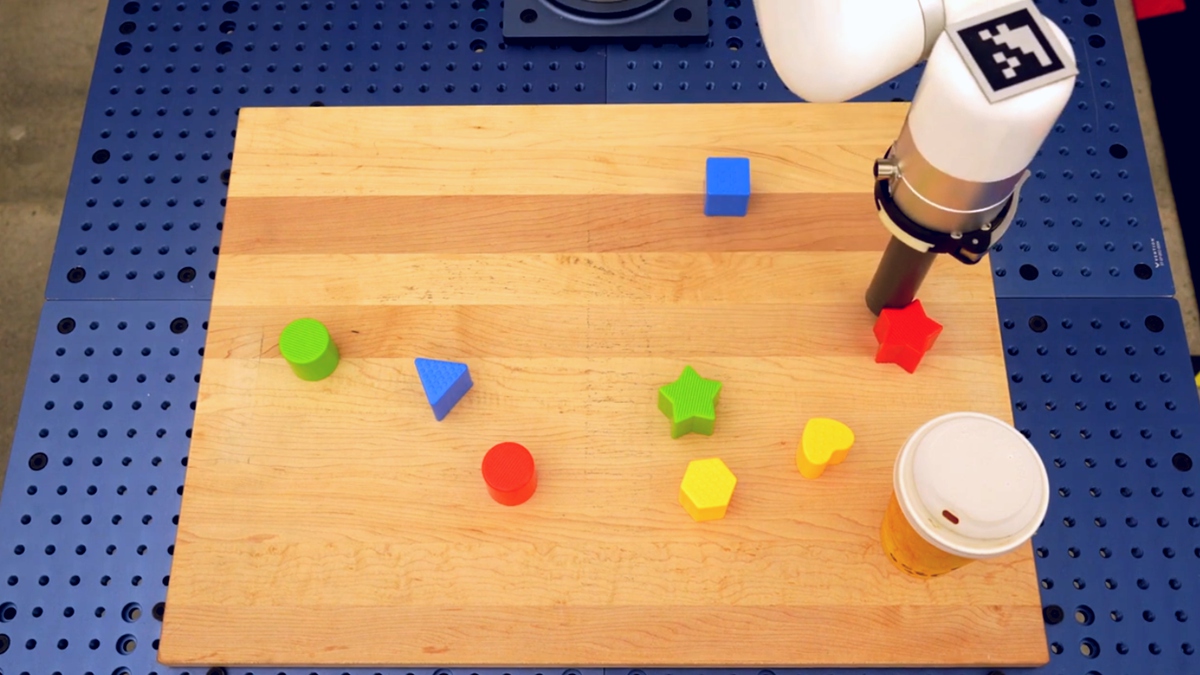

最後,在同一機器人上展示另一個範例,指令是「幫我我拿一個綠色的星星」。綠色的星星是這個機器人沒有直接接觸過的物品。

在接下來的部分中,展示了PaLM-E控制桌面機器人排列方塊。

PaLM-E可以基於視覺和語言輸入成功地規劃多個階段。它能夠成功地規劃長期任務「按顏色將方塊分類到不同的角落」。還展示了另一個多階段規劃並在長時間範圍內整合視覺回饋的示例。最後,示範了另一個長期推動任務的示例。在這個任務中,PaLM-E一步步地將指令序列化到低層策略,例如「將黃色六邊形移動到綠色星星旁」,「將藍色三角形放在一起」。

此外,還介紹了兩個泛略性的示範。在第一個範例中,指令是「將紅色方塊推到咖啡杯旁邊」。資料集中只有三個包含咖啡杯的示範,但其中沒有一個包含紅色方塊。在第二個示範中,指令是「將綠色方塊推到烏龜旁邊」。機器人能夠成功地執行這個任務,儘管它之前從未見過這隻烏龜。這兩個範例展示了模型對於未曾接觸過的物體或指令具有一定的概念化能力。

資料來源:

請注意!留言要自負法律責任,相關案例層出不窮,請慎重發文!