ADVERTISEMENT

7 月 25 日,《Nature》在一篇文章中稱,ChatGPT 已經攻破了圖靈測試,是時候要啟用其他新的方法來評估人工智慧技術了。

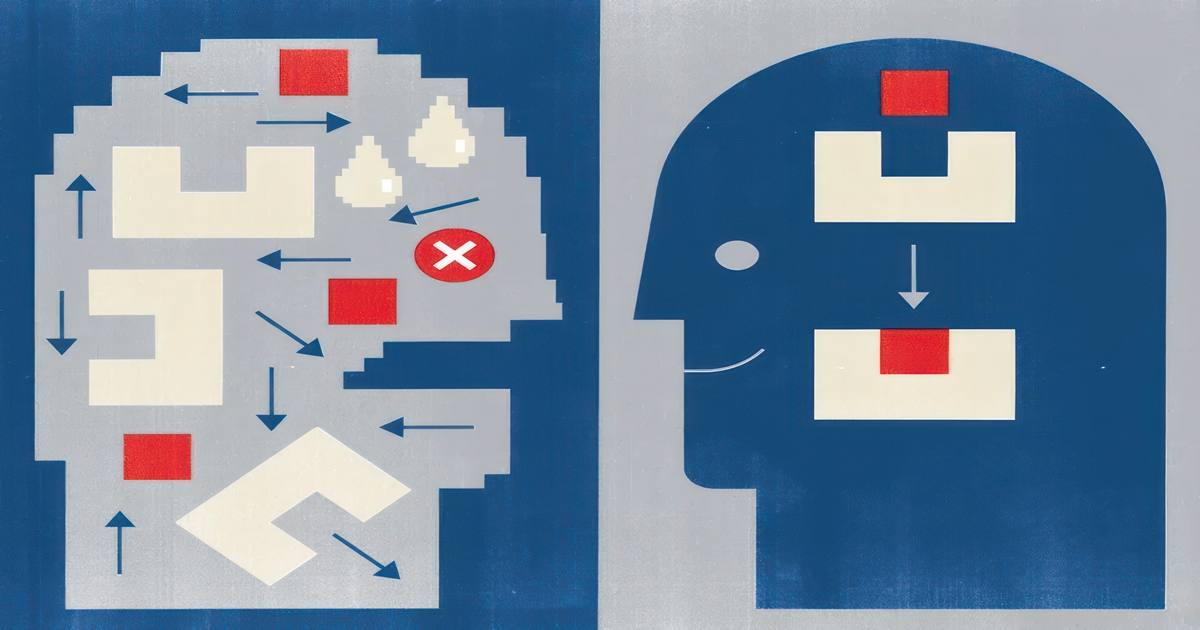

世界上最強的人工智慧(AI)系統能夠通過嚴格的考試、寫出令人信服的論文、順暢參與聊天,甚至很多人已經無法分辨 AI 與人在語言表達上有何分別。還有什麼是它們做不到的嗎?當然有,而且是些非常簡單的問題。

螢幕上排列著一系列色彩鮮豔的圖形,面對這類視覺邏輯測試,大多數人都能快速找出答案。但作為聊天機器人 ChatGPT 和搜尋引擎 Bing 背後的技術之光、當前 AI 的最高傑作,GPT-4 卻明顯力不從心。今年 5 月的一項研究顯示,GPT-4 在其中一類模式測試中的正確率只有三分之一,而在另一類測試中正確率更是可憐的 3%。

邏輯謎題背後的研究團隊,希望測試能給 AI 系統提供更好的基準,幫助解決關於 GPT-4 等大語言模型的固有短板。總結來講:在語言類測試中,大語言模型輕易就完成了曾經被視為具有里程碑意義的智慧壯舉;但在視覺邏輯測試中,它們的表現則相當孱弱、存在明顯的盲點,無法根據抽象概念做出推理。

新墨西哥州聖達菲研究所的電腦科學家 Melanie Mitchell 表示,「AI 領域的從業者們正努力解決對大語言模型系統的評估難題。」為此,她的團隊整理出了這套邏輯問題集。

過去兩、三年裡,大語言模型已經在跨多工能力上全面碾壓以往的 AI 系統。它們的工作原理並不複雜:根據訓練時接觸過的數十億線上句子,總結出各單詞之間的統計相關性,而後面對給定的輸入文本生成合理的下一單詞。對於基於大語言模型構建的聊天機器人,則額外再添加一個元素:由人類訓練師提供廣泛回饋,因此微調機器人的回應方式。

值得注意的是,在這類海量人類語言庫上訓練而成的、類似于自動補全性質的演算法,成功表現出了廣泛的問題解決能力。雖然原有 AI 系統也許在特定某項任務上能夠擊敗大語言模型,但前者必須接受與特定問題相關的數量訓練,且這種能力無法快速從一項任務轉移至其他任務。

哈佛大學認知科學家 Tomer Ullman 表示,從廣義上講,這兩大陣營的研究人員對於大語言模型的底層實現原理抱有完全相反的觀點。有些人將演算法的成就歸結於真正的推理或理解能力,但其他人(包括 Ullman 本人和前文中的 Mitchell 等研究人員)則仍持謹慎態度。

Ullamn 認為,「這場辯論的雙方都才華橫溢、水準很高。」產生分歧的根本原因,在於缺乏確鑿的證據來支持其各自觀點。「畢竟還沒有蓋革計數器那樣穩定可靠的智慧檢測器,能明確給出有智慧或者無智能的答案。」

討論雙方的研究人員表示,依靠邏輯問題等測試提示人類與 AI 系統間的能力差異,應該是向正確方向邁出的重要一步。紐約大學認知計算科學家 Brenden Lake 表示,此類基準測試還有助於揭示當今機器學習系統所缺失的能力,同時厘清人類智慧到底由哪些要素組成。

另外,這種對大語言模型及基準能力研究的測試,還具有其他現實意義。

Mitchell 指出,如果想把大語言模型應用到醫學、法律等現實場景當中,首先必須明確其能力邊界在哪裡。「我們得搞清楚它能做什麼、做不了什麼,之後才能判斷如何安全加以運用。」

圖靈測試已經過時了嗎?

在機器智慧測試領域,最著名的方案一直是圖靈測試。該測試由英國數學家兼電腦先驅艾倫·圖靈於 1950 年提出,當時的電腦尚處於起步階段。

圖靈提出了一種所謂「模仿遊戲」的評估方法,在該場景中,人類裁判分別與隱藏在螢幕之後的電腦和人類進行簡短的文本對話,看其能否據此準確辨識出機器和人。圖靈認為,這應該能回答「機器有沒有思考能力」的問題。

Mitchell 指出,圖靈並沒有詳細說明該場景的大量細節,因此缺乏確切規則可供遵循。來自谷歌的軟體工程師 François Chollet 認為,「圖靈測試並不是能在機器上實際運行的具體測試——而更多只是種思想實驗。」

但這種用語言來檢測機器是否具備思考能力的觀點,已經在技術領域根深蒂固。幾十年來,商人兼慈善家 Hugh Loebner 長期資助一年一度的圖靈測試活動,也就是「Loebner 獎」。但電腦科學家 Rob Wortham 表示,這項活動在 2019 年之後就停止了,因為隨著 Loebner 本人過世、活動經費也無以為繼。Wortham 是英國人工智慧與行為模擬研究學會的聯席主任,該學會自 2014 年開始就代表 Loebner 主辦這場競賽。他解釋道,大語言模型現在基本具備了騙過人類的能力,所以 Loebner 獎在大語言模型全面起飛前夕被迫停辦頗有種黑色幽默的意味。

其他研究人員也認為,GPT-4 等大語言模型已經基本具備了通過圖靈測試的能力。至少在簡短的對話中,多數人恐怕很難分辨誰是人、誰是大模型。

今年 5 月,以色列特拉維夫 AI21 實驗室的研究人員報告稱,有超過 150 萬人參與過基於圖靈測試的線上遊戲。使用者將參與到兩分鐘的聊天當中,面對的要嘛是另一位元使用者、要嘛是根據研究人員提示偽裝成真人的大語言模型。玩家正確辨識出機器人的機率只有 60%,已經跟完全亂猜差不多了 3。

但比較熟悉大語言模型的研究者還是能從種種細節中分辨出聊天機器人。

Chollet 指出,他發現只要利用系統的已知弱點,就能輕鬆檢測出誰是大語言模型。「如果讓我自己接受測試,判斷到底是不是在跟大語言模型聊天,那我絕對能得出正確答案。」

而其中的關鍵,就是讓大語言模型走出自己的舒適區。他的訣竅就是向大語言模型提出與常見訓練場景不同的差異化場景。在多數情況下,大語言模型都是在根據訓練資料輸出可能性最高的單詞,而並非真的按照新場景給出正確答案。

而且,Chollet 等人對於這種基於欺騙性能的測試方法持懷疑態度。「這明顯就是為了欺騙人類裁判而存在」,這樣的測試只會鼓勵開發者向 AI 灌輸更多偽裝技巧,並不能激發出更多有用或者有趣的功能。

基準測試也不可靠

研究人員經常會用評估特定能力(例如語言能力、常識推理和數學能力)的基準測試對 AI 系統做出評估,各技術團隊也越來越多採用那些專為人類設計的學術和專業考試。

今年 3 月 GPT-4 剛剛發表時,來自加州三藩市的 OpenAI 公司就在一系列專為機器設計的基準測試上評估了新模型的性能,內容包括閱讀理解、數學和編碼。據 OpenAI 報告,GPT-4 在大多數測試中表現出色 4。他們還為 GPT-4 設置了約 30 項考試,包括:面向美國高中生的各科考試,即先修課程(Advanced Placement);評估美國醫生臨床知識的考試;以及美國研究所選拔過程中使用的標準測試(GRE)。在統一律師考試(美國有多個州在律師資格考試中包含此項考試)中,GPT-4 的得分成功躋身前 10%。

AI 系統性能——結果摘錄

| 測試 | GPT-4 | GPT-3.5 | 經過專門訓練 |

| 統一律師資格考試 | 298/400 (排名前10%) |

213/400 (排名後10%) |

無 |

| 醫學知識自我評估計畫 | 75% | 53% | 無 |

| 研究所入學考試 | 163/170 (排名約前20%) |

147/170 (排名約前25%) |

無 |

| HellaSwag:常識推理 (專為機器設計) |

95.3% | 85.5% | 85.6% |

| DROP:閱讀理解基準 (專為機器設計) |

80.9% | 64.1% | 88.4% |

| GSM-8K:8000道小學數學應用題數據集 (專為機器設計) |

92% | 57.1% | 87.3% |

▲資料來源: OpenAI/ 參考文獻 4。這裡的排名百分位,為達到該分數的人類考生在全體受試者中的所在位置。

Mitchell 承認,「不少語言模型在這些基準測試中都表現良好。但多數情況下,這並不足以證明它們在一般能力上超越了人類,而是基準本身存在局限。」研究人員提出了有力的質疑,即因為模型接受了大量文本素材的訓練,所以很可能已經在訓練資料中見過類似的問題。這種情況下得出的基準測試結論被稱為「污染」,顯然不足以採信。

OpenAI 公司表示,他們透過在問題和訓練資料中查找相似字串的方式查驗過這一點。在刪除相似字串之前和之後對大語言模型做測試,其性能幾乎沒有變化。這表明極高的得分跟污染無關,但仍有部分研究人員質疑測試是否足夠嚴格。

Sam Bowman 是紐約大學的語言技術科學家,同時也在三藩市 AI 公司 Anthropic 工作。他警告稱,千萬不要簡單把 GPT-4 的考試成績視為「見過類似問題」的結果,進而否定 GPT-4 的能力。在他看來,「污染的說法確實讓情況變得有點複雜,但我認為這並沒有真正影響大局。」

研究人員還指出,大語言模型拿下考試高分的能力本身也比較脆弱,恐怕無法被轉化成在現實世界中做出正確判斷的能力。Mitchell 認為,只要稍微調整一下考試題目,就有可能導致大模型無法通過。例如,她從 ChatGPT 通過的工商管理碩士考試中選出一個問題並稍加改動,人類可以輕鬆根據變化調整答案,但 ChatGPT 卻慘遭失敗。

在解讀基準測試含義時,還有另一個更深層次的問題。對人類來說,在這些考試裡拿下高分一般都代表其具備較強的智力水準——其實智力水準本身也是個模糊概念,主要反映在一系列任務中表現出的能適應不同環境的能力。換言之,在考試中拿高分證明此人擁有較好的認知能力,而且出色掌握了某些抽象概念。但對大語言模型來說,情況則並非如此。Mitchell 強調,大模型的判斷方式跟人類非常不同,「在多數情況下,AI 系統並不是在以人類熟悉的方式做推理。」

這可能是因為大語言模型只能從語言當中學習經驗;由於缺少與現實世界連接的通道,它們無法像人那樣體驗語言跟物體、屬性和情感之間的聯繫。

Lake 指出,「很明顯,它們理解單詞的方式跟人類不一樣。」在他看來,目前的證據表明大語言模型「可以在不真正理解自己在說什麼的情況下,非常流利地使用語言。」

另一方面,大語言模型也表現出一些人類所不具備的能力,例如理解人類寫下的幾乎每個單詞之間的聯繫。Mitchell 表示,這可能代表模型是在依靠語言或者其他指標的某些特徵來解決問題,而用不著掌握更廣泛的推理能力。

OpenAI 公司研究員 Nick Ryder 也認同這一判斷,表示 AI 在單一測試中的性能表現並不足以像證明人類受試者那樣證明其普遍能力。「我覺得大家不該把人類得分跟大語言模型的得分做直接比較」,OpenAI 公佈的得分「並不是在描述大語言模型具備類人能力或者類人推理水準,而單純是展示這些模型在執行這些任務時的表現。」

在傳統機器基準測試和人類專業考試之外,研究人員還對大語言模型做出更廣泛的探討。今年 3 月,微軟研究院的 Sébastien Bubeck 及其同事就放出了題為《通用人工智慧的火花:GPT-4 早期實驗》的預發表版本 5,在行業內引起熱議。他們使用 GPT-4 的早期版本記錄下一系列令人驚訝的功能,而且其中很多功能與語言並沒有直接或明確的聯繫。其中一個值得注意的亮點,就是它能通過用於評估心理學理論的測試。心理學理論是人類的一種核心能力,用於預測和推理他人的心理狀態。他們在文章中寫道,「鑒於 GPT-4 在功能上的廣度和深度,我們有理由相信它已經代表著通用人工智慧(AGI)系統的早期(但尚不完美)版本。」

但 Bubeck 本人隨後也做了澄清,強調「GPT-4 一定不會像人那樣思考,而且對於展現出的任何功能,它都有著自己獨特的、與人類不同的實現方式。」

Mitchell 認為,儘管這份報告表述得相當激進,但卻並沒有對大語言模型的能力做出系統性探討。「這更像種人類學研究。」Ullman 也表示要想證明機器能掌握心理學理論,至少要給出與之對應的潛在認知過程證據,而不能簡單依據機器輸出了跟人類相同的答案就粗暴斷言。

AI 研究人員們認為,要想摸清大語言模型的優勢和短板,還需要展開更廣泛、更嚴格的審查。而色彩邏輯問題可能正是其中的重要一環。

新鮮謎題

2019 年,就在大語言模型全面爆發之前,Chollet 在網上發表了專門為 AI 系統整理的一套新型邏輯測試集,名為抽象與推理語料庫(ARC)。解答者將面對一段視覺演示,其中幾個正方形網格會轉變成另外一種模式,再由其指示下一網格該如何變化來證明自己已經理解了變化規則。Chollet 表示,「這測試的是我們適應以往從未見過的事物的能力」,他認為這種探尋規律的能力才是智慧的本質。

Lake 認為,ARC 把握住了「人類智慧的標誌」:從日常知識中進行抽象,並將其應用於以往從未見過的問題。

Chollet 在 2020 年組織了一場 ARC 機器人競賽,當時大語言模型還沒有獲得廣泛關注。最終獲勝的 AI 系統經過了專門訓練,善於解決 ARC 這類任務。但跟大語言模型不同,它並不具備通用功能,而且也只答對了 21% 的問題。相比之下,人類正確解決 ARC 問題的比例為 80%7。多個研究團隊目前正使用 ARC 來測試大語言模型的能力,也沒有任何一種能接近人類的表現。

Mitchell 和她的同事在 ARC 的啟發下又開發出一套新的謎題(稱為 ConceptARC),主要區別有兩點。ConceptARC 的難度更低:

Mitchell 團隊希望讓基準測試反映出機器功能的進步,哪怕只是一點點改進。第二是,該團隊選擇了特定概念來做測試,之後圍繞每個概念創建一系列與主題相關的謎題變體。

例如,為了測試相同性這個概念,一道題要求解題者將具有相同形狀的物件保持不動,另一道題則要求將同形狀物件沿一條軸對齊。這樣做的目的,是減少 AI 系統在未掌握概念的情況下通過測試的幾率。

性能不佳代表著什麼?

研究人員將 ConceptARC 任務發表給了 GPT-4 和招募來的 400 名受試人員。人類在所有概念組上的平均得分為 91%(得分最高的一組為 97%);GPT-4 得分最高的一組為 33%,在其餘概念組中的得分均不超過 30%。

Mitchell 指出,「我們證明了機器仍然達不到人類的智力水準。但令人驚訝的是,儘管從未接受過相關問題的訓練,但它還是能夠解決其中一些問題。」

該團隊還測試了在 Chollet 競賽中勝出的機器人,這些機器人並不屬於大語言模型那種通用能力系統,而是專門針對 ARC 等視覺問題訓練而成。總體而言,它們的性能比 GPT-4 更好,但還是不如人類,其中最佳概念組得分為 77%,但在大多數概念組中得分低於 60%1。

不過 Bowman 認為,GPT-4 通不過 ConceptARC 的訓練,並不證明它缺乏潛在的抽象推理能力。在他看來,ConceptARC 與 GPT-4 之間存在偏差,畢竟這是一種視覺測試。「即使這些模型真的很擅長這種概念推理,也不大可能在初次參與此類測試時就拿下高分。」

測試方式的限制,也可能是 GPT-4 表現不佳的影響因素。大語言模型的公開版本只能接受文本輸入,因此研究人員提交了用於描述圖像的數位陣列。

(例如,空白圖元可能用 0 表示,彩色廣場則可能用相應的數字表示。)相比之下,人類受試者能夠直接看到圖像。Mitchell 也承認,「我們是在拿純語言系統跟人類做比較,而人類擁有高度發達的視覺系統,所以這樣的比較恐怕並不完全公平。」

OpenAI 已經建立了 GPT-4 的「多模態」版本,能夠直接接受圖像輸入。

Mitchell 團隊正在等待該技術的正式公開,這樣就能再做一輪 ConceptARC。但她認為多模態 GPT-4 的成績也好不了多少,「我覺得這些系統仍然不具備能與人類比肩的抽象概念和推理能力。」

麻省理工學院的計算認知科學家 Sam Acquaviva 也贊同這一判斷,「否則就太讓人震驚了。」他還提到,另一組研究人員已經在 1D-ARC 基準上測試了 GPT-4,且模式限制為單行而非網格 8。這應該能消除一定的不公平問題,但 Acquaviva 看到雖然 GPT-4 的性能有所提高,但同樣不足以證明大語言模型具備可靠的規則理解和推理能力。

推理論證

Bowman 還提到其他一些實驗,綜合結果來看,大語言模型至少已經掌握了推理抽象概念的基本能力。在其中一個案例中,哈佛大學電腦科學家 Kenneth Li 和他的同事採用了黑白棋的數位版本,由對弈雙方將黑色和白色棋子放進 8 x 8 的網格當中。他們希望借此評估大語言模型到底是依賴記住的語言統計關係來生成文本,還是真的能像人類一樣為現象構建內部表徵。

在向大語言模型提交人類選手的操作訓練集之後,AI 很快就掌握了為下一步棋選擇正確策略的能力。研究人員認為,這表明大語言模型甚至能夠理解棋盤上的態勢,並結合當前特徵給出棋步建議,這明顯突破了文本形式的束縛 9。

Bowman 承認,大語言模型的推理能力總體上可謂是「參差不齊」,而且達不到人類推理的高度。但他認為這種推理能力確實存在,而且似乎會隨著模型規模的增長而提升。也就是說,未來的大語言模型會表現得越來越好。

「這些系統沒有我們期待中那麼可靠或者通用,而且在某些特定的抽象推理方面完全搞不清狀況。但我認為,它們的基本推理能力確實客觀存在。」

Bowman 和 Mitchell 等研究人員還一致認為,如何更好地測試大語言模型抽象推理及其他智慧指標的方法,仍然是個懸而未決的問題。斯坦福大學認知科學家 Michael Frank 認為不可能存在單一某種包羅萬象的測試能夠全面取代圖靈測試。相反,他認為研究人員需要設計大量測試來量化各類系統的優勢和短板。「這些智慧體都很棒,只是在諸多方面仍有缺陷,所以最重要的就是對此開展系統性探索。」

Wortham 則向剛剛接觸 AI 系統的朋友們提出建議,希望儘量遠離那種對擬人化的執念。「我們總想把任何表現出智慧的東西理解成人,這真的很沒必要。」

「這甚至可說是種詛咒,意味著除了人類自己,我們無法想像其他表現出明確目標導向的智慧形式。我們總是一廂情願地認為,它這麼做的深層思維方式跟自己一樣。」

資料來源:

- ChatGPT broke the Turing test — the race is on for new ways to assess AI

- The ConceptARC Benchmark: Evaluating Understanding and Generalization in the ARC Domain

- Turing, A. M. Mind LIX, 433–460 (1950).

- Article Google Scholar

- Human or Not? A Gamified Approach to the Turing Test

- GPT-4 Technical Report

- Sparks of Artificial General Intelligence: Early experiments with GPT-4

- On the Measure of Intelligence

- Fast and flexible: Human program induction in abstract reasoning tasks

- LLMs and the Abstraction and Reasoning Corpus: Successes, Failures, and the Importance of Object-based Representations

- Emergent World Representations: Exploring a Sequence Model Trained on a Synthetic Task

請注意!留言要自負法律責任,相關案例層出不窮,請慎重發文!