ADVERTISEMENT

記憶體一直是不太熱門的產業,最常見的新聞就是跟「景氣循環」寫在一起。但近期,記憶體大廠開始佔據外媒科技版首頁,並跟一組關鍵字有緊密的連動──HBM。

HBM是高頻寬記憶體,作為重要的供應商,海力士2023年的股價攀升86%、美光更大漲近70%。背後主要的原因,還是離不開AI,甚至離不開輝達(NVIDIA)。

文章目錄

到底什麼是HBM,為什麼在AI時代成為眾人追捧的關鍵?

HBM是什麼?

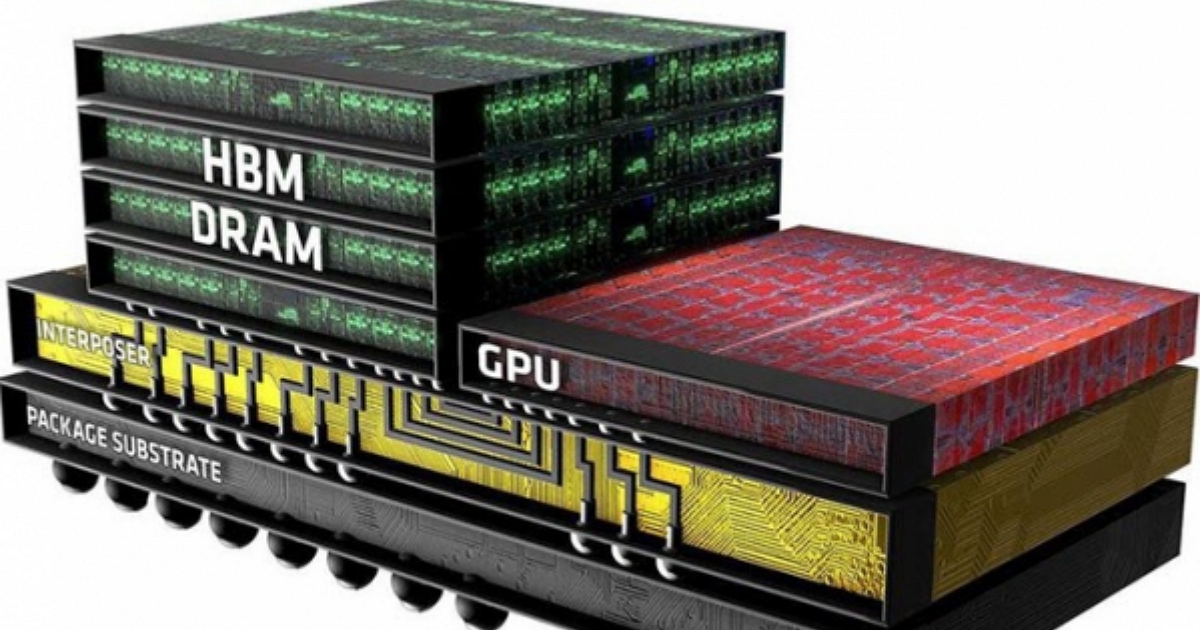

高頻寬記憶體(High Bandwidth Memory,HBM)是三星電子、AMD和SK海力士發起的一種基於3D堆疊工藝的高效能DRAM,適用於高記憶體頻寬需求的應用場合,像是圖形處理器、網路交換及轉發裝置(如路由器、交換器)等。首款使用高頻寬記憶體的裝置是AMD Radeon Fury系列顯示核心。

2013年10月,高頻寬記憶體正式被JEDEC採納為業界標準。第二代高頻寬記憶體(HBM2)於2016年1月被JEDEC採納。NVIDIA在該年發表的新款旗艦型Tesla運算加速卡 —— Tesla P100、AMD的Radeon RX Vega系列、Intel的Knight Landing也採用了第二代高頻寬記憶體。

HBM跟傳統DRAM有什麼不同?

簡單來說,越強的AI處理器,需要越強的記憶體。

美光副總裁暨運算與網路事業部運算產品事業群總經瓦伊迪亞納坦(Praveen Vaidyanathan)指出,晶片性能表現與記憶體的頻寬和容量成正相關,隨著大語言模型(LLM)參數量增加,也需要更高頻寬記憶體,AI處理器才能順利運行。

HBM相較傳統DRAM為高頻寬記憶體。高頻寬就好比是高速公路,道路越寬可承受的車流量就越大,換句話說頻寬越高,記憶體能運送的資料量就越大。《SemiAnalysis》指出,光GPT-4就含1.8兆個參數,想應用AI,就必須搭配像HBM這樣容量更大、存取更快速的記憶體,讓參數可以輕易被傳輸與儲存。

HBM是由大眾所熟知的DRAM(動態隨機存取記憶體)堆疊,再透過3D IC先進封裝而成。如同蓋積木般,透過先進封裝將DRAM做3D立體堆疊,加大頻寬與儲存空間,與一般DRAM之間並不存在取代關係,而是因為應用需求的不同,衍生出的技術。

HBM技術難在哪?

技術聽起來簡單,然而卻有不少須突破的技術障礙。瓦伊迪亞納坦指出3項技術難點:

首先,是厚度。HBM厚度僅能為人類頭髮的一半,意味著每一層DRAM的厚度都必須控制,研磨必須相當精細。瓦伊迪亞納坦指出:「一旦堆疊層數越多,DRAM就必須做的更薄。」在這樣的狀況下,企業必須擁有更先進的DRAM製程才可能達成。

其次,是晶圓堆疊的精準度。HBM的封裝是將每一片DRAM晶圓疊齊後再做切割,切割下來的晶粒就是HBM。不過,製造商為讓堆疊更薄,會在矽晶圓上穿孔並以金屬物質填滿,用以通電,藉此取代傳統封裝的導線架。這樣的打洞技術則稱為「矽穿孔(TSV, Through Silicon Via)。」

倘若是堆疊4層的HBM,從晶圓堆疊切割前開始,就必須精準對齊矽穿孔(TSV),「切的時候也不能移位,否則不能導電。」瓦伊迪亞納坦說。由於矽穿孔僅略大於細菌尺寸,需要非常精細的工藝才能做到。

第三,就是堆疊後的散熱問題。HBM之所以被發明,來自於晶片商希望能將記憶體和處理器,包含CPU和GPU,全都包在一顆IC中。如此一來,記憶體與處理器的距離變得比之前近很多,散熱問題更需要被解決。綜合三點來看,封裝技術的重要性更甚以往。

HBM的應用有哪些?除了AI伺服器,還有哪些也會用到HBM?

由於技術難度高,成本也相對高昂。早在2013年HBM就已經誕生,當時超微(AMD)找上海力士共同研發第一代HBM,卻因價格太貴而鮮少被晶片業者採用,直至今日才因為AI應用而崛起。

晶片業者分析,雖然越先進的HBM價格越高,但只要效能夠好、夠省電,廠商當然願重本採用,「不然黃仁勳(輝達執行長)要怎麼喊出『買越多、省越多』的口號。」

那麼,HBM市場在哪呢?目前來看,AI伺服器會是HBM最重要的市場,美光以及海力士的HBM3e已通過輝達的驗證,市場更盛傳輝達已支付數億美元的預付款以確保供應。瓦伊迪亞納坦指出:「AI伺服器所需要的記憶體量,是傳統伺服器的5~6倍。」

美光副總裁暨運算與網路事業部運算產品事業群總經瓦伊迪亞納坦告訴記者,GPU的性能表現與記憶體的頻寬和容量成正相關 圖/ 貝查理攝影

除此之外,未來自駕車市場也是HBM重要的應用場景。Mordor Intelligence在10月出版的一份報告中表示,自駕車與ADAS(自動駕駛輔助系統)正在推升HBM的需求。從這個情況看來,AI伺服器+車用的HBM市場需求,可能將長達10年。

HBM背後的記憶體廝殺戰!海力士市佔最高、美光靠技術搶市

在這樣的情況下,HBM也成為記憶體巨頭的最新戰場。集邦科技指出,作為先進者的海力士,在2022年拿下近全球近5成HBM市佔奪冠,居次的三星佔4成、美光佔1成。《BusinessKorea》報導,三星將在2024年積極擴產HBM以追上海力士腳步。而看似落後的美光,希望在HBM戰局中,用技術吹響反攻號角。

如同台積電的3、5奈米,DRAM也有製程迭代,排序為1y、1z、1α(1-alpha)、1β(1-beta)和1γ(1-gamma),其中1β是當前已量產的最先進記憶體,1γ則還未量產。若進一步比較,最新一代的HBM3e,三星採用的是1α製程,海力士與美光皆用1β製作,於技術上領先三星。投資銀行分析師指出,美光是希望藉著HBM技術領先,搶攻市場龍頭。

不過,HBM目前最大的挑戰是「良率」。

日本微細加工研究所所長湯之上隆於1月的專欄指出,雖然HBM技術門檻較高,但其售價比DRAM高出10倍以上,商業誘因充足。因此,即便HBM的良率低於50%,仍是記憶體製造商無法輕易放棄的市場。

集邦科技則進一步指出,下一代的HBM預計將於2026年推出,堆疊層數也會自現有的12層增加至16層,2027年有機會問世,屆時先進封裝技術和良率角色將更為吃重。

全球記憶體市場長久以來三分天下,HBM受到重視後則開啟全新戰局,甚至可能扭轉局勢。在先進技術優先、成本其次考量的AI時代,記憶體比起以往將扮演更重要的角色。

本文轉載自:數位時代

請注意!留言要自負法律責任,相關案例層出不窮,請慎重發文!