ADVERTISEMENT

NVIDIA與VMware合作所開發並推出AI-Ready Enterprise平台,透過NVIDIA AI Enterprise套件與VMware vSphere虛擬化技術,運行AI作業負載,協助產業發揮AI應用潛能。

加速虛擬化程式部署

NVIDIA企業與邊緣運算部門副總裁暨總經理Justin Boitano提到,目前世界各地的AI運算都還是運作於裸機伺服器(Bare Metal Server),應用彈性與部署速度不如虛擬機器靈敏。而NVIDIA AI Enterprise套件能讓客戶能夠將開發AI模型的時間,從原本的80週縮短到僅8週,也讓客戶能夠以與裸機同等的橫向擴展性和加速運算效能,並可便捷在VMware vSphere上部署及管理進階AI應用。

在AI Enterprise套件與vSphere的協助下,IT人員可以透過用來管理大規模資料中心及混合雲環境的相同工具來支援AI,NVIDIA軟體套件除了可以在vSphere上提供具橫向擴展的多節點AI應用效能,表現表現也與裸機伺服器相差無幾,能為醫療照護領域的進階診斷、製造業的智慧工廠、金融服務領域的詐欺偵測等AI應用注入龐大運算效能。

GPU也支援虛擬化

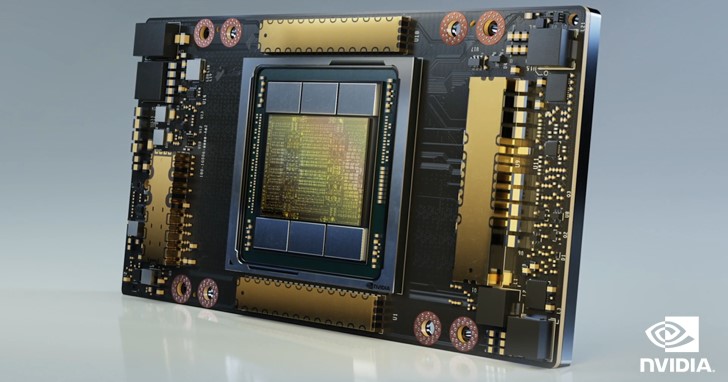

AI Enterprise套件相容於多種在混合雲環境中運行的大量加速CUDA應用程式、AI框架、預先訓練好的模型及軟體開發套件。在經過最佳化調整後的作業負載可以橫跨多個節點,以完全的GPU虛擬化支援大型的深度學習訓練模型。

VMware vSphere 7 Update 2也已經通過認證,可以搭配NVIDIA多執行個體 GPU(Multi-Instance GPU,MIG)技術進行即時遷移的運算虛擬化軟體,將NVIDIA認證系統上的NVIDIA A100 Tensor Core GPU在硬體層面分割成最多7個執行個體,將各種規模的作業負載執行效率提升到最高。

舉例來說,系統管理員可以建立2個各具有20 GB記憶體的MIG執行個體,也可以建立3個各具有10 GB的執行個體,或是建立7個各具有 5 GB 的執行個體,又或者是將幾個執行個體混合起來。系統管理員可針對不同類型的工作負載,為使用者提供大小合適的GPU,或是以動態方式調整,比方白天可以使用7個執行個體進行低輸送量推論,並在夜間重新設定為1個大型執行個體,進行深度學習訓練,大大增加使用彈性。

另外,NVIDIA ConnectX智慧網路卡也取得VMware vSAN over RDMA (Remote Direct Memory Access,遠端直接記憶體存取)認證,這項技術能夠減輕通訊任務的處理器負擔,提高應用程式的執行效能與基礎設施的投資報酬率。

NVIDIA AI Enterprise套件以永久授權的方式提供,每個處理器插槽的費用為美金3,595元(約合新台幣102,890元),NVIDIA AI Enterprise套件的企業級標準支援服務的年費為每張許可證美金899元(約合新台幣25,730元)。客戶預計升級VMware vSphere 7 Update 2之前,也可透過官方網站申請早期試用NVIDIA AI Enterprise。

請注意!留言要自負法律責任,相關案例層出不窮,請慎重發文!