ADVERTISEMENT

對於AI來說,完成一個單一任務或許相對簡單,但是涉及到合作和博弈時,AI往往顯得有些愚蠢。

AI研究機構一直致力於透過一些涉及到合作和博弈的遊戲來開發AI在這方面的能力。

在2019年,OpenAI開發的「捉迷藏AI」透過5億輪次的訓練成功學會了在遊戲中相互合作和與對手博弈。

近期,Deepmind將這方面的研究又向前推進了一步。

根據7月27日Deepmind官方部落格的介紹,Deepmind最新的AI智慧體可以在沒有玩過一款遊戲的前提下,能夠對全新的條件做出反應,並且玩完一整套遊戲,而這一切的背後居然是Deepmind搭建的一款遊戲「metaverse」。

我們來看看怎麼回事。

Deepmind的AI各種出人意表的怪招不斷

論文總是枯燥的,所以我們先來看看Deepmind的示範,看看這些AI在沒玩過這些遊戲的情況下,是如何透過各種怪招贏得遊戲的。

這是OpenAI之前探索過的捉迷藏遊戲,下面這張圖中正在追趕的是藍色的AI小人,左上角是它的第一視角,而躲藏的是紅色AI小人。

為了躲避藍色小人的追捕,紅色小人果斷進入了一個從未探索過的陌生地域,還順手將一塊板子橫在身後。提醒大家的是,雙方AI都沒有玩過這款遊戲。

不過,藍色AI小人也不是吃素的,在另一個地圖上,藍色AI小人追丟了自己的目標,但是他結合地形發現了更好的追捕方法——登上制高點。最終,紅色AI小人被抓到了。

上面是一款博弈的遊戲,下面我們來看一款相互合作的遊戲。遊戲的目標很簡單,兩個AI只要有一個到達一個高臺上的紫色塔尖就行,於是當其中一個AI成功將一款板子搭到了高臺上,任務便成功完成了。

不過這遠沒有結束,目標是接觸到塔尖,而不是非得爬上去,所以AI又成功發現了另一個更簡單的方法,直接用一款板子將紫色塔尖砸下來不久行了。

下一個遊戲也是合作類的,目標是阻止紫色的球滾落到紅色的地面。這次遊戲兩個AI一共探索了三種方法,第一種是用自己的身體擋住小球,顯然,這個方法比較效率比較差;

第二種方法是借助兩側的牆面,將小球擠到牆角不動就行;

最後,AI發現了一個最簡單的方法,直接將小球放到一塊板子上,小球不就永遠不會跟地板接觸了,nice~

最後再來看一個登頂小遊戲,兩個AI比賽,成功站立在白色高臺上的獲勝,首先是藍色AI小人先找到了白色高臺並且登了上去,在它以為自己已經獲勝的時候,紅色AI小人直接過來,將藍色AI小人幹掉,自己留在了白色高臺上。

上面幾款遊戲都是AI從未玩過的,但顯然AI在接觸一會之後,都會成功找到獲勝的方法,這中間有的是依靠合作,有的則需要博弈。

Deepmind的這個成就讓大家似乎見到了通用人工智慧的曙光,也許在人類看來這些AI或許還很笨,但是最起碼,他們不再每玩一個遊戲就要訓練上億次了。

這一切,都要歸功於Deepmind打造的遊戲「metaverse」。

為了讓AI智慧體學會舉一反三,Deepmind打造包含數十億任務的遊戲「metaverse」

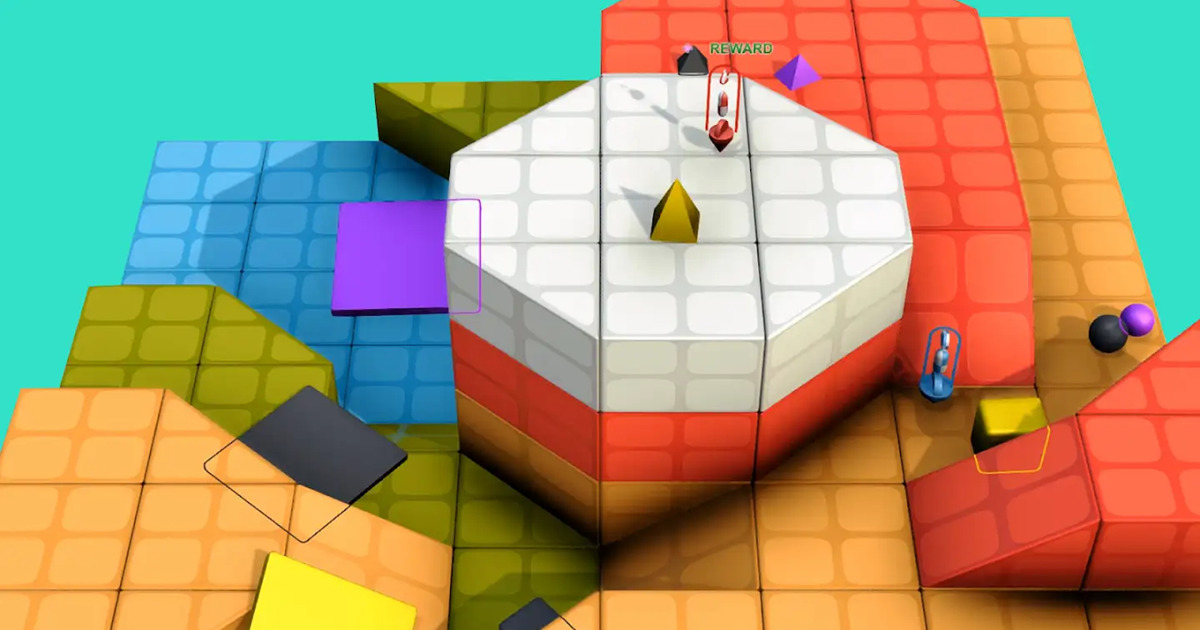

為了達到輕易上手各種遊戲的效果,Deepmind為這些AI智慧體打造了一個包含數十億遊戲任務的「metaverse」,名為XLand。

在這個遊戲「metaverse」中,無數的「遊戲星球」組成了「遊戲星系」,每個星球上的遊戲按競爭性、平衡性、可選則性、探索難度四個緯度進行區分。

比如左上角那個例子,遊戲雙方需要將小球趕到自己的區域才算獲勝,「不是你死就是我亡」,一點合作的機會都沒有,所以它的競爭性指標直接被拉滿了。

而右上角那個遊戲,則是要求將幾何體按顏色歸類到一起,多個智慧體合作完成任意一組配對就可以,所以競爭性很低,但是可選擇性很強。

在學習的過程中,Deepmind讓這些智慧體AI由易到難開始學習,不斷補齊在競爭性、平衡性、可選則性、探索難度這是個方面的短板,每成功解鎖一個遊戲,AI都會獲得獎勵,從而一步一步變成遊戲大師。

除了由易到難的訓練順序,Deepmind的研究人員的訓練方法也很符合人類的習慣,通過估計遊戲的子目標,要想達到勝利,需要先完成什麼,後完成什麼,這樣一步步持續引導智慧體的注意力。

同時,為了讓智慧體更加多才多藝,獲得更加泛化的能力,研究人員設定在學習時,每個新任務都要基於通關的舊任務生成,保持學習的連續性。

最終,透過四次反覆運算,產生出的第五代就可以更好的適合各種環境,各種合作和博弈任務。最後的第五代AI智慧體在XLand 4000多個「星球」中一共玩了70萬個遊戲,經歷了2000億次訓練,完成了340萬個獨特任務。

這樣的開放式訓練讓一些基於強化學習的智慧體甚至可以達到零樣本學習。

這種面對任務一看就會的AI,離我們心裡的通用人工智慧還有多遠?

請注意!留言要自負法律責任,相關案例層出不窮,請慎重發文!