ADVERTISEMENT

只需3秒鐘,一個根本沒聽過你說話的AI,就能完美模仿出你的聲音。

這是微軟最新AI成果——語音合成模型VALL‧E,只需3秒語音,就能隨意複製任何人的聲音。

它脫胎於DALL‧E,但專攻音訊領域,語音合成效果在網上放出後引起相當的關注了:

DALL-E generates pixels from text. Now meet its cousin, VALL-E, that generates audio from text @MSFTResearch!

— Jim Fan (@DrJimFan) January 6, 2023

VALL-E’s resemblance to DALL-E v1 and Parti @GoogleAI is striking. Image and audio are both continuous signals, but they can be quantized into discrete tokens.

1/ pic.twitter.com/CLiGKhFKoD

有網友表示,要是將VALL‧E和ChatGPT結合起來,效果簡直爆炸:

看來與GPT-4在Zoom裡聊天的日子不遠了。

還有網友調侃,(繼AI搞定作家、畫家之後)下一個就是配音演員了。

所以VALL‧E究竟怎麼做到3秒鐘模仿「沒聽過」的聲音?

用語言模型來分析音訊

基於AI「沒聽過」的聲音合成語音,即零樣本學習。

語音合成趨於成熟,但之前零樣本語音合成效果並不好。

主流語音合成方案基本是預訓練+微調模式,如果用到零樣本場景下,會導致生成語音相似度和自然度很差。

基於此,VALL‧E橫空出世,相比主流語音模型提出了不太一樣的思路。

相比傳統模型採用梅爾頻譜提取特徵,VALL‧E直接將語音合成當成了語言模型的任務,前者是連續的,後者是離散化的。

具體來說,傳統語音合成流程往往是「音素→梅爾頻譜(mel-spectrogram)→波形」這樣的方式。

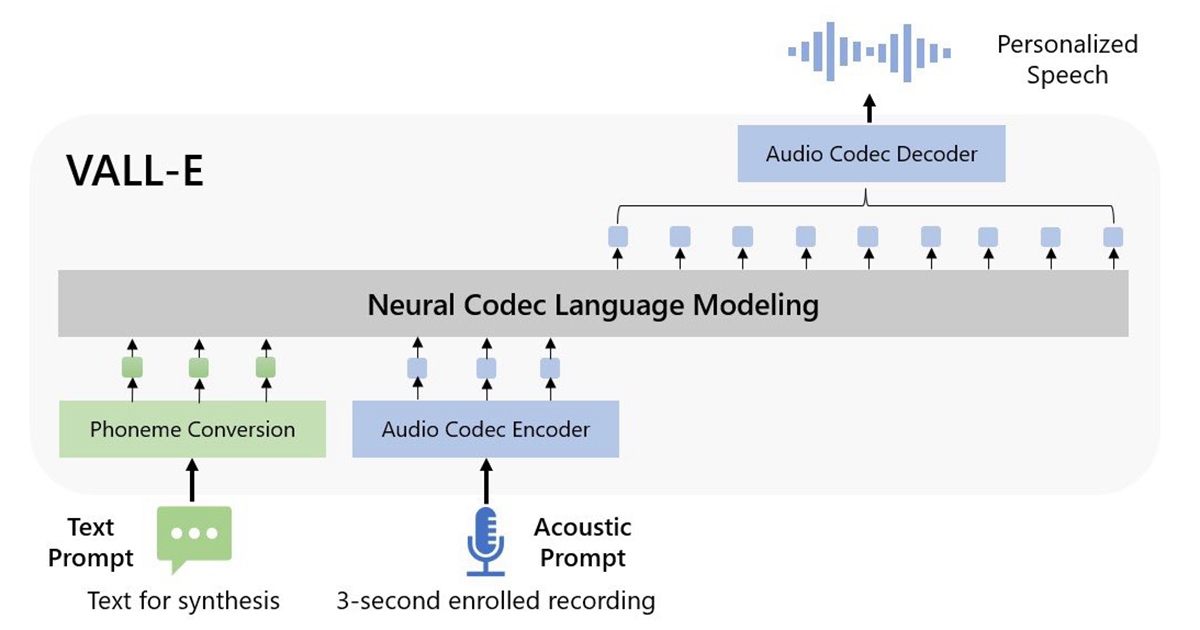

但VALL‧E將這一流程變成了「音素→離散音訊編碼→波形」:

具體到模型設計上,VALL‧E也和VQVAE類似,將音訊量化成一系列離散tokens,其中第一個量化器負責捕捉音訊內容和說話者身份特徵,後幾個量化器則負責細化訊,使之聽起來更自然:

隨後以文本和3秒鐘的聲音提示作為條件,自回歸地輸出離散音訊編碼:

VALL‧E還是個全能選手,除了零樣本語音合成,同時還支援語音編輯、與GPT-3結合的語音內容創建。

那麼在實際測試中,VALL‧E的效果如何呢?

連環境背景音都能還原

根據已合成的語音效果來看,VALL‧E能還原的絕不僅僅是說話人的音色。

不僅語氣模仿到位,而且還支援多種不同語速的選擇,例如這是在兩次說同一句話時,VALL‧E給出的兩種不同語速,但音色相似度仍然很高:

同時,連說話者的環境背景音也能準確還原。

除此之外,VALL‧E還能模仿說話者的多種情緒,包括憤怒、睏倦、中立、愉悅和噁心等好幾種類型。

值得一提的是,VALL‧E訓練用的資料集不算特別大。

相比OpenAI的Whisper用了68萬小時的音訊訓練,在只用了7000多名演講者、6萬小時訓練的情況下,VALL‧E就在語音合成相似度上超過了經過預訓練的語音合成模型YourTTS。

而且,YourTTS在訓練時,事先已經聽過108個演講者中的97人聲音,但在實際測試中還是比不過VALL‧E。

有網友已經在在想像它可以應用的地方了:

不僅可以用在模仿自己的聲音上,例如幫助殘障人士和別人完成對話,也可以在自己不想說話時用它代替自己發語音。

當然,還可以用在有聲書的錄製上。

Wondering if @EMostaque or Eleuther AI has a team working on a publicly available version of VALL-E. https://t.co/YONfC85Nr8

— Ralph Brooks (@ralphbrooks) January 6, 2023

不過,VALL‧E目前還沒開源,要想試用可能還得再等等。

論文連結:

音訊試聽連結:

請注意!留言要自負法律責任,相關案例層出不窮,請慎重發文!