ADVERTISEMENT

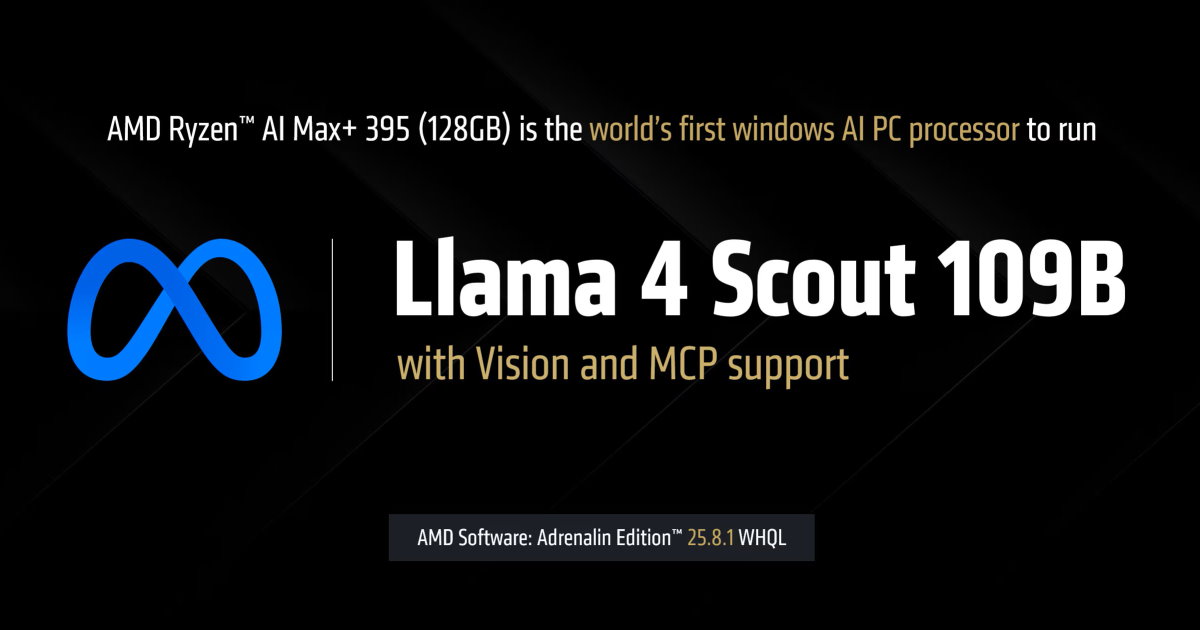

AMD宣布將透過AMD Software: Adrenalin Edition 25.8.1版驅動程式,讓搭載Ryzen AI Max+ 395處理器並配備128GB記憶體電腦能執行約與ChatGPT 3.0相當的128B參數的大型語言模型。

筆電、小型工作站也能跑超大模型

由於大型語言模型(LLM)的參數量會影響執行時占用的顯示記憶體,可能會超過個人電腦顯示卡的容量上限,因此往往需要仰賴雲端服務。AMD推出的Ryzen AI Max+ 395處理器整合現今最強的內建顯示晶片,具有40組RNDA 3.5繪圖架構運算單元,並可在系統安裝128 GB主記憶體時,切割其中96 GB做為專屬顯示記憶體使用,並搭配16 GB共享記憶體,帶來執行參數量更龐大模型的可能性。

延伸閱讀:

CES2025:AMD發表多款行動版處理器,Ryzen 9 9955HX3D、Ryzen Z2、以及超大內建顯示的Ryzen AI Max

CES2025:AMD Ryzen AI Max + 395、Ryzen Z2筆電、迷你電腦、掌上型電腦全線出擊

Framework推出Desktop桌上型電腦,採AMD Ryzen AI Max + 395處理器還可選貓扇

AMD宣布AMD Software: Adrenalin Edition 25.8.1版驅動程式,將可讓搭載Ryzen AI Max+ 395處理器與128 GB主記憶體的電腦在本地執行參數量高達128B的大型語言模型,並支援具備完整視覺功能與模型上下文協定(Model Context Protocol,以下簡稱MCP)的Meta Llama 4 Scout 109B模型。

其中關鍵就是AMD可變顯示記憶體技術(Variable Graphics Memory,VGM),最高能切割容量高達96 GB的連續專用顯示記憶體給予內建顯示晶片,如此一來能夠在沒有安裝獨立顯示卡的前提下,於本地端執行FP4資料類型的128B參數模型,或FP16資料類型的32B參數模型。

讀者可以下載最新版LM Studio以及AMD Software: Adrenalin Edition預覽版(或更新版本)嘗試這些功能。

檔案下載

LM Studio:https://lmstudio.ai/

AMD Software: Adrenalin Edition 25.10 RC 24預覽版:https://www.amd.com/en/resources/support-articles/release-notes/RN-RAD-WIN-25-10-RC-24-RYZEN-AI-MAX-395-VULKAN-LLAMA.html

支援Llama 4 Scout MoE

在可變顯示記憶體技術加持下,搭載Ryzen AI Max+ 395處理器與128 GB主記憶體的電腦能夠執行參數量更龐大的大型語言模型,甚至能夠透過MCP與其他應用程式溝通,達到自動透過瀏覽器查詢資料,或是閱讀、搜尋使用者私有檔案、資料庫中的資訊,進一步提升代理式AI(Agentic AI)功能的完整性與豐富度。

AMD也進一步說明,Llama 4 Scout屬於混合專家模型(Mixture-of-Experts,MoE),它整體具有109B參數量,運作時可以僅啟動其中的17B參數(但完整的109B參數仍需儲存於顯示記憶體中),有助於提高AI推論運算效能,讓系統達到每秒15組字詞(Token)的輸出速度。

另一方面,原本LM Studio的預設上下文窗口為4,096字詞,如今在搭配Ryzen AI Max+ 395處理器與128 GB主記憶體的情況下,執行Llama 4 Scout時能擴增至256,000字詞,大幅提高推理式AI與代理式AI的功能性。

▲AMD提供透過Llama 4 Scout推導馬克士威方程組的推理過程展示影片。

▲AMD提供透過MCP與應用程式協作的展示影片。

AMD表示MCP的正處於快速擴展的發展階段,Meta、Google、Mistral等模型開發商也在訓練AI模型的過程中增加調用應用程式與工具的「技能」,可以預見未來的模型將更能加善各類工具,強化大型語言模型的「智力」。

請注意!留言要自負法律責任,相關案例層出不窮,請慎重發文!