ADVERTISEMENT

NVIDIA於美國華盛頓特區展開GTC DC大會,執行長黃仁勳除了分享對AI發展的趨勢分析,也介紹多樣技術資訊,並在舞台上展示Vera Rubin Superchip。

透過GPU加速各種運算

黃仁勳在GTC DC大會的開幕演說中,以摩爾定律放緩為引。隨著半導體製程技術漸漸碰觸到物理極限,電晶體的尺寸難以持續縮小,造成單一晶片的效能成長也隨之放緩,為了解決這個問題,黃仁勳表示透過GPU進行加速運算就是個明確的解方。

延伸閱讀:

【NVIDIA GTC DC 2025】黃仁勳:當 AI 摩爾定律放緩,就用加速運算與外部擴展解決問題

NVIDIA於GTC DC 2025大會(下):Vera Rubin Superchip登場,打造超級資料中心數位孿生與物理AI

Hot Chips 2025:NVIDIA發表Spectrum-XGS Ethernet,實現Scale-Across分散式運算

NVIDIA於AI Infra Summit 2025發表Rubin CPX GPU,透過分離運算提升6倍AI推論效能

NVIDIA於GTC 2023春季展發表多樣AI技術,帶來更多生成式AI還能用AI加速晶片設計與生產

黃仁勳表示NVIDIA提供多款以CUDA運算架構為基礎的加速運算API(應用程式介面),並以與Nokia合作的ARC(Aerial RAN Computer,無線電接入網天線電腦)為例,透過AI協助6G網路基礎系統強化無線頻譜、束波成型的管理,以提升通訊品質。

另一方面NVIDIA也發表NVQLink連接量子電腦的量子處理器(QPU),透過繪圖處理器(GPU)強大的平行運算能力為量子位元進行即時錯誤校正。

透過Scale-Across彌補摩爾定律放緩

黃仁勳也重提AI運算的3個擴展法則,其中預訓練(Pre-Training)為透過大量資料進行AI基礎模型的訓練,而後訓練(Post-Training)則是針對使用需求,輸入特定專業領域的資料對模型進行微調,而推論中思考(Test-Time Training)則指所謂的長思考或是推理式AI,在AI推論運算的過程中,透過思維鏈(Chain of Thoght)的方式讓AI系統反覆進行思考推論,以提高答案的精準度。

另一方面,黃仁勳也分析了AI生態系統的循環趨勢。當企業透過AI服務營利之後,將利潤投入擴建AI基礎設施,如此一來就能提高服務品質以及同時上線的使用者人數,以賺取更多利潤。

至於另一個解決摩爾定律放緩的方式,就是透過外部擴展解決問題。傳統上擴產電腦效能的方式有Scale-Up與Scale-Out,前者可以理解為更換效能更強的運算單元,以提高單一伺服器的效能,後者則是串聯多台伺服器,提高整體效能輸出。

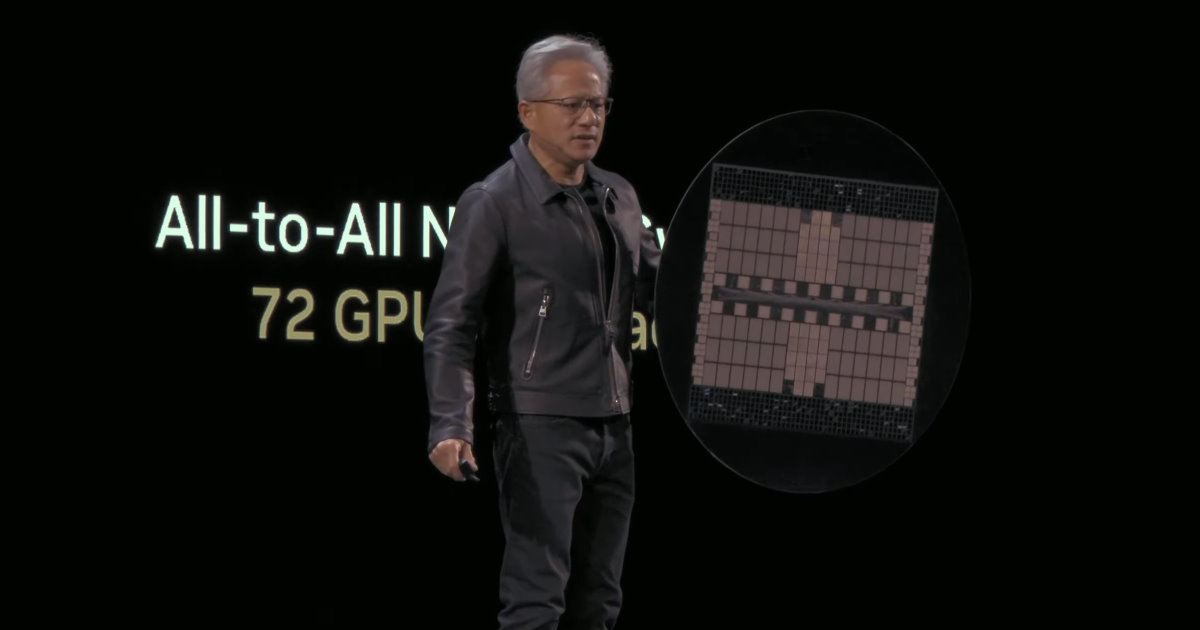

以NVIDIA的產品為例,Grace Blackwell NVL72機櫃內整合72組Blackwell GPU,彼此透過NVLink互聯技術整合為單一運算叢集,對軟體與應用程式而言它就像是1顆效能優異的超大型GPU,發揮類似於Scale-Up的效果。而各機櫃還可以透過InfiniBand或Ethernet(乙太網路)等方式進行Scale-Out擴展。

黃仁勳則再次重申先前在Hot Chips 2025大會提到的Scale-Across分散式運算概念。透過超低延遲、高頻寬的資料交換技術,串聯位於不同地理位置的資料中心,將多座獨立的資料中心整合為單一超級AI工廠,以滿足超大量體(Giga-Scale)AI運算需求。

黃仁勳也在演說中提到Vera Rubin Superchip與相關產品,並介紹了超級資料中新數位孿生與物理AI等技術進展,筆者將在下篇文章中繼續說明。讀者可以參考文首的延伸閱讀連結。

請注意!留言要自負法律責任,相關案例層出不窮,請慎重發文!