ADVERTISEMENT

NVIDIA於AI Infra Summit 2025發表支援分離運算的Rubin CPX GPU,讓2組運算單元同時負責單一AI推論運算的不同部分,最高能提升6倍AI推論效能。

化解AI推論的瓶頸

NVIDIA於AI Infra Summit 2025(人工智慧基礎設施高峰會)帶來最新MLPerf Inference基準測試成績以及Rubin CPX GPU(繪圖處理器,適合用於AI運算)等重要資訊,其中後者是能大幅提升AI推論效能的新型態GPU。

延伸閱讀:

【GTC 2025】黃仁勳演說深入分析:提出「終極摩爾定律」,追求相同耗電更高效能

NVIDIA於AI Infra Summit發表最新MLPerf Inference基準測試結果,透過分離運算提升近50%效能

LLM(Large Language Model,大型語言模型)的推論運算過程可以分為2個階段,第1階段為前後文分析與預填寫(Context / Prefill),主要的運算效能瓶頸會落在GPU本體,若GPU的運算效能不足就會對AI推論的字詞(Token)輸出速度造成顯著負面影響。第2階段則為生成與解碼(Generation / Decode),瓶頸會轉移到資料吞吐量,需要更高的記憶體頻寬以及晶片間傳輸(C2C)頻寬來舒解資料阻塞的情況,確保字詞輸出速度不受影響。

NVIDIA利用分離運算(Disaggregated Serving)的方式,將AI推論運算的2個階段拆分給不同GPU執行,其中特化GPU(如衍生型的Rubin CPX GPU)負責第1階段,並將KV Cache(Key-Value快取)資料傳輸給典型GPU(如Rubin GPU)進行第2階段運算,透過2種針對不同需求最佳化的運算單元來化解各階段效能瓶頸的,能帶來6倍於僅使用典型GPU的吞吐量。

小辭典:KV Cache

簡單地說,在Transformers類型的AI模型中,系統會透過查詢(Query,Q)前文字詞的配對鑰匙(Key,K)與內容值(Value,V)等屬性,以生成下一組字詞。

而KV Cache則是將先前運算所得到的K、V向量值儲存於快取記憶體,優點是往後要若使用的話,不需重新運算即可直接讀取結果,但是缺點就是佔用更多記憶體空間與傳輸頻寬。

上述2個工作階段的第1階段(預填)中,系統會將提示詞(Prompt)中的所有字詞運算以取得K、V向量值,並將結果儲存於KV Cache。在第2階段(解碼)時,系統只需計算新生成字詞的Q、K、V向量,並將新的Q向量與KV Cache中的K向量進行配對,然後再讀取KV Cache中的V向量生成結果,能夠以「找查快取記憶體替代實際運算」,以大幅降低運算量並提升效能。

Rubin CPX GPU內服外用兩相宜

Rubin CPX GPU是針對上述第1階段工作特性進行最佳化的特化版GPU,具有30PFLOPS的NVFP4資料類型理論運算效能,搭配128GB GDDR7顯示記憶體,能夠分擔典型版Rubin GPU執行AI推論的運算負載。

值得注意的是,Rubin GPU搭配Rubin CPX GPU運算時,最高能夠達到6倍於單獨使用Rubin GPU的吞吐量,發揮1加1大於2的效能增益。

另一方面,Rubin CPX GPU內整合NVENC硬體影像編碼器、NVDEC硬體影像解碼器各4組,能在伺服器需要輸入或輸出影片時,透過硬體加速的方式降低處理器(CPU)以及GPU的負擔。

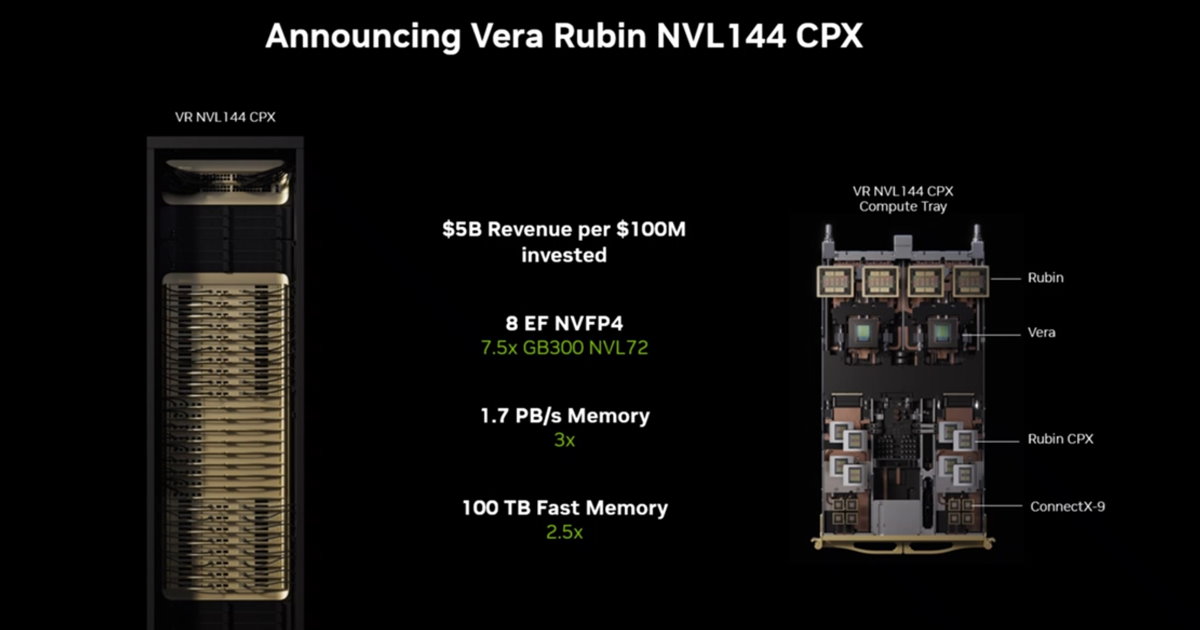

NVIDIA目前發表2種Rubin CPX GPU組態,第1種為Vera Rubin NVL 144 CPX,它以由18組伺服器構成的Vera Rubin NVL 144機櫃為基礎,在每組伺服器中加裝4組Rubin CPX GPU,能在不額外增加佔用空間的前提下提高整體運算效能。

第2種則為雙機櫃組態,在現有Vera Rubin NVL 144機櫃旁邊設置Vera Rubin CPX機櫃,並透過ConnectX-9網路卡連接。Vera Rubin CPX機櫃由18組伺服器構成,每組伺服器內具有2組Vera CPU以及4組Rubin CPX GPU,提供日後升級的彈性選項。

NVIDIA也發表了超大型AI工廠(AI Factory Giga-Scale)的參考設計,包含從建築工程到營造,到發電、儲能、機械、電力、管路等等環節的設計、模擬、營運,協助企業提升AI工廠建置速度。

考慮到GPU就是AI工廠中最重要的生產樞紐,我們輸入資料、經過GPU運算、產生AI模型或推論結果,當GPU數量越多代表AI工廠的獲利也越高。NVIDIA表示每投資1億元建置Vera Rubin NVL 144 CPX,即可獲得50億元的營收。

Rubin CPX GPU預定於2026年上市,這種「怪給西」當然是沒有零售的啦!

> Rubin CPX應該for 第一階段, Rubin是for第二階段

感謝提醒,已修正內文