ADVERTISEMENT

人工智慧圖像產生(AI image generation)在很大程度上已經實現了。一個新發布的名為「Stable Diffusion」的開源圖像合成模型,可以讓任何擁有一台 PC 和一個像樣一點 GPU 的人,將文本轉化為圖像。這個 AI 作畫工具幾乎可以模仿任何視覺風格,如果你輸入一個描述性短語,圖像就會像魔術一樣出現在你的螢幕上。

人工智慧圖像產生(AI image generation)在很大程度上已經實現了。一個新發布的名為「Stable Diffusion」的開源圖像合成模型,可以讓任何擁有一台 PC 和一個像樣一點 GPU 的人,將文本轉化為圖像。這個 AI 作畫工具幾乎可以模仿任何視覺風格,如果你輸入一個描述性短語,圖像就會像魔術一樣出現在你的螢幕上。

有些藝術家對此技術的前景感到興奮,有些則不然,而整個社會似乎仍然沒有意識到 AI 作畫所帶來的廣泛影響。可以說,圖像合成技術帶來的影響堪比照相機的發明,或者堪比視覺藝術本身的創造。甚至我們的歷史感也可能受到威脅,這取決於事態的發展。無論如何,Stable Diffusion 正引領一波深度學習創新工具的新浪潮,這必將徹底改變視覺媒體的創作。

1. 「AI 作畫」的興起

Stable Diffusion 是倫敦前對沖基金經理伊馬德·穆斯塔克(Emad Mostaque)的創意,他的目標是透過自己的公司 Stability AI 為大眾帶來深度學習的新應用。但是現代圖像合成的根源可以追溯到 2014 年,Stable Diffusion 並不是今年第一個引起轟動的圖像合成模型(ISM)。

2022 年4月,OpenAI 發布了 DALL-E 2,它能夠將文字寫出來的場景(稱為prompt)轉換成無數的視覺風格,震驚了社群媒體,這些視覺風格可以是夢幻的、奇妙的和逼真的。有人使用這個工具創造了「騎馬的太空人、在古埃及買麵包的泰迪熊、著名藝術家風格的新奇雕塑」等等。

在 DALL-E 2 之後不久,Google和 Meta 也宣布了他們自己的文本轉圖像 AI 模型。接著,MidJourney 自 2022 年 3 月起可以透過 Discord 伺服器存取,幾個月後向公眾開放,收費使用,並實現了類似的效果。

在 DALL-E 2 之後不久,Google和 Meta 也宣布了他們自己的文本轉圖像 AI 模型。接著,MidJourney 自 2022 年 3 月起可以透過 Discord 伺服器存取,幾個月後向公眾開放,收費使用,並實現了類似的效果。

然後是 Stable Diffusion。8 月 22 日,Stability AI 發布了其開源圖像產生模型,其品質可以說與DALL-E 2 相當。它還推出了自己的商業網站 DreamStudio,出售使用 Stable Diffusion 產生圖像的運算時間。與 DALL-E 2 不同的是,任何人都可以使用它,而且由於 Stable Diffusion 程式碼是開源的,因此專案可以在幾乎沒有限制的情況下被構建。

僅在過去一周,就有數十個將 Stable Diffusion 帶入全新方向的專案如雨後春筍般湧現。人們使用一種名為「img2img」的技術獲得了意想不到的結果,它「升級」了 MS-DOS 遊戲美術,能將《我的世界》(Minecraft)的遊戲圖像轉換為逼真的圖像,將《阿拉丁》中的場景轉換為 3D,將孩子般的塗鴉轉換為豐富的插圖,等等。圖像合成技術可以讓廣大使用者的想法變成視覺化的圖像,降低了進入門檻,同時也加強了那些擁抱該技術的藝術家的能力,就像 1990 年代的 Adobe Photoshop 所做的那樣。

如果你願意遵循一系列有些晦澀難懂的步驟,就可以自己在本地運行 Stable Diffusion。在過去的兩周裡,我們一直在一台搭載 Nvidia RTX 3060 12GB GPU的 Windows PC上運行這個模型。它可以在大約 10 秒內產生一個 512×512 圖像。在 3090 Ti 顯示卡下,每幅圖像的產生時間下降到 4 秒。Stable Diffusion 的介面也在快速最佳化,更友好和完善的介面很快就會出現。所以,如果你對技術不感興趣,請堅持住,更簡單的解決方案即將推出。如果本地運行失敗了,你也可以嘗試線上示範。

2. Stable Diffusion 是如何工作的?

從廣義上講,最近的 ISM 浪潮中的大多數都使用了一種被稱為潛在擴散(latent diffusion)的技術。基本上,該模型學會了在純雜訊(pure noise)中辨識熟悉的形狀,然後如果這些元素與 prompt 中的單詞匹配,則逐漸將這些元素聚焦起來。

首先,訓練該模型的人或小組用中繼資料(如在網上找到的圖片標籤和標題)來收集圖像,形成一個大型資料集。在 Stable Diffusion 的案例中,Stability AI 使用了 LAION-5B 圖像集的一個子集,這基本上抓取了網路上 50 億張可公開存取的圖像。最近對資料集的分析顯示,許多圖像來自 Pinterest、DeviantArt 甚至 Getty images 等網站。因此,「Stable Diffusion」吸收了許多在世藝術家的風格——這也遭到了其中一些藝術家的強烈反對。下面會詳細介紹。

接下來,該模型使用數百個高階 GPU(如 Nvidia A100)在圖像資料集上進行自我訓練。根據創始人穆斯塔克(Mostaque)的說法,到目前為止,「Stable Diffusion」的訓練成本為 60 萬美元(其他 ISMs 的訓練成本估計通常在數百萬美元左右)。在訓練過程中,模型透過一種名為 CLIP(對比語言-圖像預訓練)的技術,將單詞與圖像關聯起來,該技術是由 OpenAI 公司在去年發明並公布的。

透過訓練,一個使用潛在擴散(latent diffusion)的 ISM 學會了在某個主題中,特定顏色像素之間的關係。所以雖然它不一定能在高水準上「理解」他們的關係,但結果仍然可以是令人驚歎和驚訝的,可以使推理和風格組合看起來非常聰明。訓練過程完成後,該模型永遠不會複製源集中的任何圖像,而是可以根據所學的內容創建新穎的樣式組合。這樣做的結果可能是令人愉快的,且非常有趣。

目前,Stable Diffusion 並不關心一個人是否有三隻手、兩顆頭,還是每隻手上有 6 根手指,所以除非你是創造 prompt 文本提示的天才,(AI藝術家有時稱之為「提示工程」),否則你可能需要產生大量圖像,並從中挑選出最好的圖像。請記住,提示與資料集中已知圖像的標題匹配得越多,就越有可能得到你想要的結果。在未來,很有可能模型會得到足夠的改進,進而增加精度,減少挑選的必要,或者某種內部篩檢程式會為你提前挑選好。

3. 倫理和法律方面的擔憂比比皆是

如上所述,Stable Diffusion 的公開發布已經開始讓一些人擔心了,這些人擔心它對文化和經濟的影響。與 DALL-E 2 不同,Stable Diffusion 的訓練資料可供任何人使用,沒有任何硬性限制。官方發布的 Stable Diffusion(和DreamStudio)包括自動的「NSFW」篩檢程式和嵌入在圖像中的不可見的跟蹤浮水印,但這些限制可以在開放原始碼中輕鬆繞過。這意味著,Stable Diffusion 可以被用來創建 OpenAI 目前禁止用 DALL-E 2 產生的圖像,比如暴力圖像、色情圖像、可能侵犯公司版權的圖像、名人造假圖像等。事實上,已經有一些專用的 Discord 伺服器專門用於該模型的色情圖片輸出。

需要明確的是,Stable Diffusion 的許可證正式禁止了其中的許多用途,但隨著程式碼和權重的公開,實施起來會非常困難,甚至是不可能的。當被問及這些問題時,穆斯塔克(Mostaque)表示,他認為公開這種工具的好處超過了潛在的缺點。在一次簡短的採訪中,他告訴我們,「我們相信個人責任和代理,同時制定了道德政策和工具來減輕其帶來的傷害。」

此外,Stable Diffusion 在推特上引起了藝術家們的憤怒,因為模型有模仿在世藝術家風格的能力。用於訓練 Stable Diffusion 的圖像集包含了從在世藝術家那裡收集的數百萬幅藝術作品,而沒有與藝術家提前進行協商,這引發了關於作者和版權的深刻倫理問題。根據美國的法律先例,收集資料似乎是合法的,但有人可能會辯稱,這項法律落後於快速發展的技術,而這些技術已經顛覆了公共資料的利用方式。

因此,如果圖像合成技術在未來被大公司採用(這可能很快就會實現,因為穆斯塔克說「我們與 Adobe 有合作關係」),公司可能會根據一個「乾淨的」資料集來訓練自己的模型,其中包括授權內容、選擇加入的內容和公共領域的圖像,以避免這些道德問題——即使使用網路搜索在技術上是合法的。我們問穆斯塔克他是否有這方面的計畫,他回答說:「Stability 正在研究一系列的模型,我們自己和合作者的所有模型在所屬的管轄範圍內都是合法的。」

Stable Diffusion 的另一個問題是文化偏見。由於這些 ISMs 目前的工作方式是抓取網路上的圖像及其相關中繼資料,因此它們也學會了資料集中存在的社會和文化刻板印象。例如,在其 Discord 伺服器上的 Stable Diffusion 測試版中,早期的測試人員發現,幾乎每次輸入「美女」時,出現的圖像都有點裸體的意思,這反映了西方社會經常在網路上描述女性的方式。其他文化和種族歧視的刻板印象在 ISM 訓練資料中隨處可見,因此研究人員警告說,如果沒有適當的保護措施,它就不應該在生產環境中被使用。這可能也是其他強大的模型,如 DALLE-2 和Google的 Imagen 仍然沒有廣泛向公眾提供的原因之一。

儘管一些人工智慧研究人員對資料集品質和偏見的擔憂反響強烈,但網路仍然是帶有中繼資料的圖像的最大來源,而這些資料是可以免費存取的。因此對於 ISMs 的開發人員來說,它總是一個誘人的目標。試圖手動為數百萬或數十億的圖像編寫描述性的文字說明,以建立一個全新的倫理資料集,目前在經濟上可能是不可行的。因此,雖然網路上的資料帶有偏見,但要想讓這項技術成為可能,也只能這樣了。由於不存在跨文化的普遍世界觀,圖像合成模型在多大程度上過濾或解釋某些想法,可能仍將依賴未來使用該技術的不同群體的價值判斷。

4. 接下來會發生什麼?

縱觀計算領域的歷史趨勢,我們可以大膽設想,現在需要強大的 GPU 才能實現的東西,未來很有可能最終會在智慧型手機上實現。「Stable Diffusion 很可能在一年之內就能在智慧型手機上運行。」穆斯塔克告訴我們。此外,新技術將允許在較便宜的設備上訓練這些模型。我們可能很快就會看到,由人工智慧推動的創意產出將出現爆炸式增長。

Stable Diffusion 和其他模型已經開始著手動態影片產生了,所以去期待「不久之後就能透過文本提示產生逼真的影片」這件事吧。在此基礎上,將這些功能擴展到音訊和音樂、即時影片遊戲和 3D VR 體驗也是合乎邏輯的。很快,先進的人工智慧可能只需要一些提示,就能完成大部分創造性的繁重工作。想像一下即時、按需產生的無限娛樂,「我希望它是多模式的,」穆斯塔克說,「這樣你可以創造任何你能想像的東西,就像《星際奇航》的全像甲板(Holodeck)體驗一樣。」

ISMs 也是一種了不起的圖像壓縮方式:Stable Diffusion 需要數億張圖像,並將有關這些圖像的資訊壓縮到一個 4.2 GB 的權重檔中。透過正確的種子和設置,可以確定地再現某些產生的圖像。可以想像,人們在未來使用這種技術的變體,將一部 8K 故事片壓縮成幾百萬位元組的文本。一旦成真,任何人都可以用這種方式創作自己的故事片。這項技術的意義才剛剛開始被探索,所以它可能會把我們帶到目前無法預見的新方向上。

由於前面提到的原因,如此逼真的圖像合成模型具有潛在的危險,例如製造和宣傳錯誤資訊、篡改歷史和冒充他人等,以及還會破壞照片或影片證據的法律價值。在人工智慧驅動的未來,我們如何知道哪些圖像是真的,哪些圖像是假的?穆斯塔克對此類問題相對樂觀,他說:「到時候會有新的驗證系統出現。」

當然,這說起來容易,而我們也很容易對新事物感到害怕。儘管我們盡了最大努力,但如果沒有看到影像合成和其他人工智慧驅動的技術得到廣泛應用,就很難確切知道它們將如何影響我們的社會。最終,人類將會適應,即使我們的文化框架最終可能會在這個過程中發生根本性的變化。這種情況以前也發生過,這也是為什麼據說古希臘哲學家赫拉克利特說:「唯一不變的就是變化。」

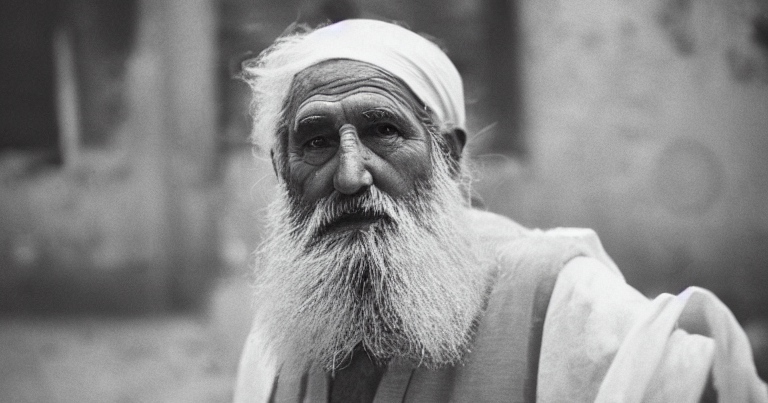

事實上,現在有一張他說這句話時的照片,這還要歸功於 Stable Diffusion。

請注意!留言要自負法律責任,相關案例層出不窮,請慎重發文!