ADVERTISEMENT

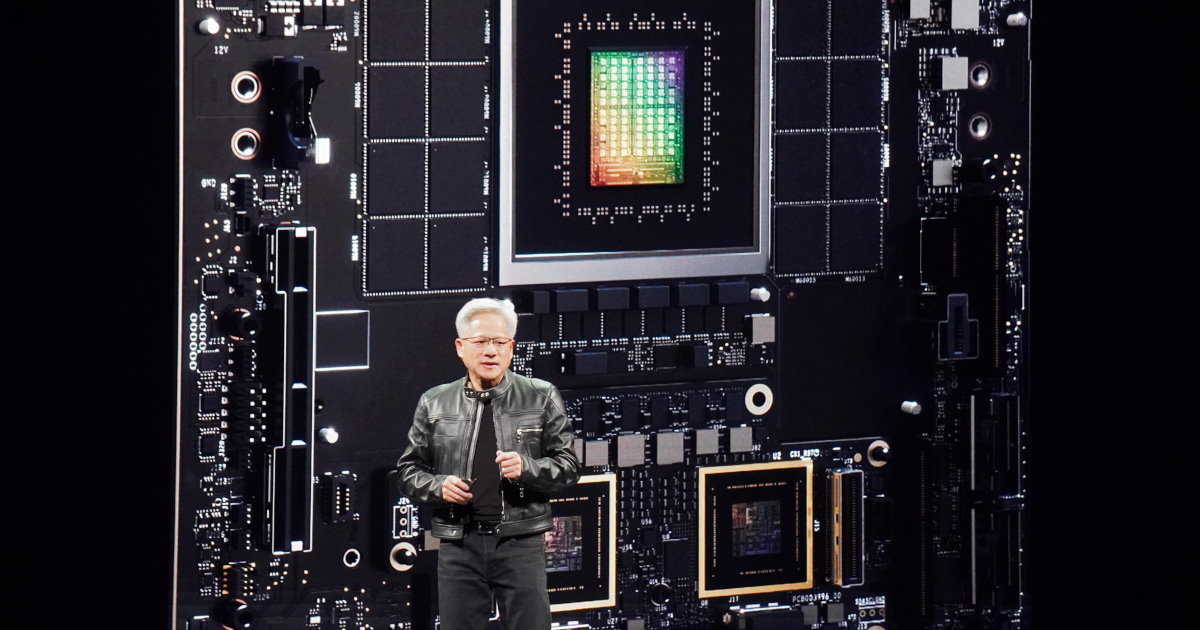

NVIDIA透過NVLink匯流排串起多組GPU,發揮擴展運算效能以及可用記憶體容量的成效,以提高AI運算的效能與能夠容納的模型參數量。

2種不同擴展方案

(回到系列文章目錄)

為了要在下篇文章解釋NVIDIA於Computex台北國際電腦展2025發表的NVLink Fusion,筆者需要先說明NVLink是什麼東西,請各位讀者忍耐一下比較艱澀的講解。

資料中心的效能擴展基本上有2種方式,Scale Up(縱向擴展)為提高單一運算單元的效能,Scale Out(橫向擴展)則為串連多組運算單元。舉例來說,如果一個工廠每天可以生產100件貨物,Scale Up比較像是升級至生產速度2倍的新型生產線,而Scale Out則是蓋第2間廠房但使用相同生產線,2者都能達到每天生產200件貨物的效果。

然而2種方案在AI運算各有限制,Scale Up受到於晶片開發高效能的技術限制,以及單一晶片的供電、散熱等物理限制。Scale Out則會因多組運算單元之間的資料同步、虛耗而折損效能,且需要設置更多伺服器,占用更多資料中心的樓地板面積。

NVIDIA於2021年發表的Grace CPU就導入NVLink匯流排,透過這種晶片對晶片互連技術(Chip-to-Chip,C2C),建立CPU(中央處理器)與GPU(繪圖處理器,能夠加速AI運算)之間的高速傳輸通道,提升整體運算效能。

2024年發表的GB200 NVL72系統,則是透過第5代NVLink互連技術將8組GB200 Superchip運算節點連接為猶如單一大型GPU的運算單元,其中總共包括36組Grace CPU與72組B200 GPU。若是搭配NVLink Switch機架級交換器晶片,最高能將576組B200 GPU組成無阻塞運算網狀架構的完全互連GPU,發揮類似Scale Up的效能擴展效果。

AI運算著重資料交換

另一方面,NVDIA於2019年收購Mellanox後,也將InfiniBand網路互連技術應用於AI運算伺服器的Scale Out,串起多組由NVLink組成的運算節點,進一步提升整體運算單元的規模。根據NVIDIA官方網站說明,InfiniBand能夠連接數十萬組GB200 Superchips。

(筆者註:原文如下,Multiple racks can be connected with NVIDIA Quantum InfiniBand to scale up to hundreds of thousands of GB200 Superchips.)

值得注意的是,無論在AI訓練或AI推論等運算過程中,除了運算效能之外,記憶體容量是相當重要的規格指標,若位於GPU或是由CPU管轄的記憶體容量不足,可能就會造成運算效能驟降或是甚至無法完成運算的狀況。

但是在單一GPU上搭載的記憶體容量受到成本考量、散熱、供電,以及GPU本身效能與記憶體匹配效率(若GPU效能不夠強,搭載過多記憶體對效能沒有幫助)等因素的綜合考量。舉例來說NVIDAI的GB200 Superchip最多搭載480 GB LPDDR5X以及384 GB HBM3e記憶體,而AMD Instinct MI350系列則搭載288 GB HBM3e記憶體。

若需要訓練或使用規模更大、參數量更多的AI模型,勢必需要透過各種Scale Up與Scale Out技術擴展運算單元的數量,進而存取更大容量的記憶體。

NVIDIA透過NVLink、InfiniBand與乙太網路等互連方式達到Scale Up與Scale Out等擴展功效,提高整體運算效能並支援量體更大的AI模型。筆者將在下篇文章說明NVLink Fusion。

(回到系列文章目錄)

請注意!留言要自負法律責任,相關案例層出不窮,請慎重發文!