在這次受矚目的人機對弈中,AlphaGo最終以4:1的佳績戰勝南韓棋王李世乭,它是由Google旗下公司DeepMind所開發的一套人工智慧系統,現場實際對戰的棋手兼幕後推手黃士傑於2011年以論文「應用於電腦圍棋之蒙地卡羅樹搜尋法的新啟發式演算法」取得國立台灣師範大學博士學位,同時他也是AlphaGo的主要程式開發者,這次的勝利被黃士傑稱之為人工智慧進展的里程碑。

▲Google台灣董事總經理簡立峰做簡單開場。

圍棋歷史悠久且難度高,一度成為人工智慧夢靨

黃士傑博士提到圍棋已有3000年的歷史,匯集了中國源遠流長的文化大成於一身,古稱琴棋書畫的「棋」就是指圍棋,全世界下圍棋的人數總共有4000萬人,他本身也是業餘六段的圍棋棋手。圍棋的難度在於它的複雜度很高,雖然規則簡單,但卻有10的170次方可能的盤面,變化總數比全宇宙的原子數還多,若真的要探究第一步最好的棋應該下在哪個位置,需要考慮到的變化基本上就是天文數字,所以圍棋被視為人工智慧的大挑戰。下圍棋需要棋手的直覺和計算能力,所以用電腦下圍棋非常困難,甚至可視為人工智慧的夢靨,自從1997年IBM的深藍打敗世界西洋棋王後,圍棋成為僅存尚無法突破的遊戲,而這次的勝利就是一個很大的突破。

黃士傑博士舉例說明西洋棋棋盤上有80個點,下第一步後還有79個點,而圍棋則有361個點,第二步棋就必須思考360個點,若一盤棋平均有150步,總盤面大概就是10的360次方,即使用電腦去暴力窮舉也可能幾億年都窮舉不完,因此困難處在於電腦找不到最佳解,最後考慮到圍棋除了計算以外的直覺特性,並利用這個特性來解決圍棋的難題。

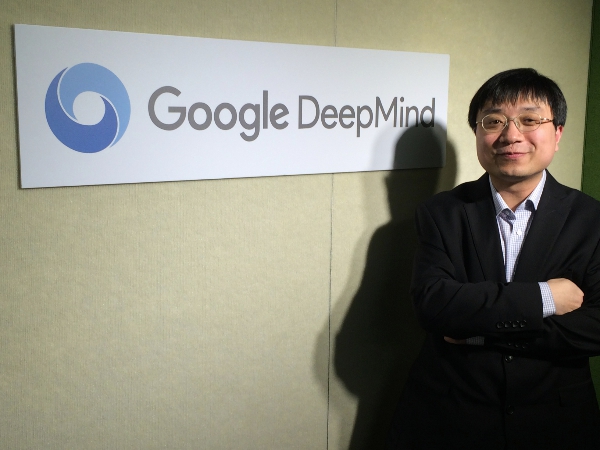

▲黃士傑博士解析AlphaGo。

AlphaGo的厲害之處在於它與深度學習結合

黃士傑博士表示AlphaGo能夠打敗職業九段的關鍵在於它有兩個主要的網路:策略網路和值網路,舉例來說,360個棋步中,策略網路會找出前20個最好的棋步,剩下的340步就可以不必考慮,而AlphaGo從人類的2、30萬個棋譜當中去學習最好的20個棋步,因此AlphaGo是吸取前人所有的成果,並非排除人類的研究成果。值網路則是做為判斷盤面之用,在搜索到某個點的時候來判斷優勢方為何。總結來說,策略網路只需要思考20步,因此可以減少搜索的廣度;而值網路透過搜尋前面幾步來得知優勢或劣勢,故大幅減少搜索的深度,這就是AlphaGo成功的祕訣,AlphaGo也會藉由每天與AlphaGo的對弈來做強化式學習,以提升自身能力。

▲黃士傑博士解說策略網路及值網路。

針對一些賽後引起討論的疑問,黃士傑博士也做出回應,他表示AlphaGo賽前並沒有針對李世乭九段做任何特別的訓練,賽前也不會知道勝率有多少,必須在比賽開始後才會收集到足夠的資訊對棋局做出判斷,雖然在現場下棋的黃士傑看不到,但後台會有個圖表顯示勝率,若勝率低於20%,AlphaGo就會做出投降的決定。至於為什麼AlphaGo會在第四局吞下敗仗,開發團隊也努力地在尋找詳細的原因,而AlphaGo的下一步應用會是什麼,團隊還沒有討論出明確的方向,不過DeepMind裡面已經有團隊開始將人工智慧的技術應用在醫療上,相信會為醫學診斷帶來很大的幫助。

請注意!留言要自負法律責任,相關案例層出不窮,請慎重發文!