Google研究人員於4月4日線上發表一篇論文,首次公佈了用於訓練人工智慧模型的超級電腦的技術細節,並宣稱該系統比NVIDIA的超算系統更快且功耗更低。

Google新發表的這篇題為《TPU v4:用於機器學習的光學可重構超級電腦,硬體支援嵌入》的文章介紹了Google自己設計的定製TPU晶片。Google目前90%以上的人工智慧訓練工作都使用這些晶片。

TPU v4:專為機器學習而設計的超級電腦

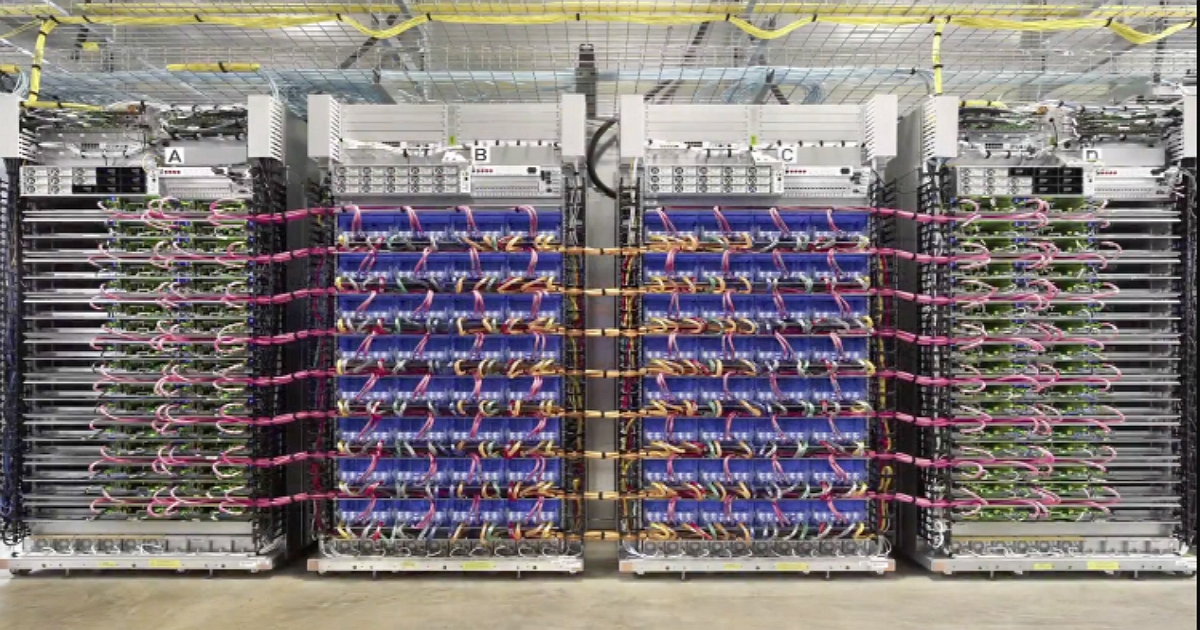

TPU v4是一款專為機器學習而設計的超級電腦,其硬體架構包括多個TPU晶片和光學電路開關(OCSes)。每個TPU v4芯片包含一個ASIC和四個HBM堆棧,並使用液冷技術進行散熱。TPU v4還具有SparseCore,這是一種數據串流處理器,可加速DLRM模型中的嵌入式技術。

光學電路開關OCSes和底層光學元件在價格上相對便宜,僅佔總成本的不到5%,總功率消耗不到3%。 OCSes可以動態重新配置其互連拓撲結構以提高規模、可用性、利用率、模組化、部署、安全性、功率和性能。

Google表示已經將4000多個TPU晶片連接成一台超級電腦,這些晶片通過協同來訓練模型。目前各家科技公司都在競爭AI超級電腦系統,以支撐起人工智慧大模型的算力。Google的AI聊天機器人Bard正在奮力追趕OpenAI的ChatGPT,這意味著大量的資料已經無法儲存在單個晶片上。

Google表示,其AI超級電腦可以輕鬆地動態調整晶片之間的連接,有助於提升超級電腦的性能。「電路切換將能更輕鬆地繞過故障元件。」Google研究員Norm Jouppi和Google傑出工程師David Patterson寫道,「這種靈活性甚至允許我們改變超級電腦互連的拓撲結構以加速機器學習模型。」

速度比NVIDIA A100晶片系統還快1.7倍

Google在論文中表示,對於同等大小的系統,其TPU晶片比基於NVIDIA A100晶片的系統快1.7倍,能效高1.9倍。不過Google沒有將其第四代TPU晶片與NVIDIA目前最新版的旗艦人工智慧GPU晶片H100進行比較,H100擁有800億個電晶體,並採用更新的N4(4奈米)晶片製造工藝。

Google還暗示,該公司正在開發下一代的TPU,將與H100競爭,但沒有提供任何細節。

根據先前市場分析資料,在AI大模型方面,NVIDIA的A100佔據了約95%的市佔率。針對Google是否已經全面轉向使用自研晶片來訓練人工智慧模型,NVIDIA未予評論。不過一位NVIDIA方面技術人士表示:Google同時使用NVIDIA的晶片和Google自己的晶片,很多時候競爭與合作是並存的。

雖然Google現在才公佈有關其超級電腦的詳細資訊,但自2020年以來,Google一直在公司內部位於俄克拉荷馬州梅斯縣的資料中心接入超級運算系統。 Google表示,AI圖像生成公司Midjourney也使用該系統訓練其模型。

「Google一直都在嘗試擺脫NVIDIA晶片的統治,但是這並沒有說起來那麼容易。」Gartner晶片分析師表示,「NVIDIA也是做了幾十年才能夠坐穩現在的行業地位,Google的TPU目前還是自用為主。」

請注意!留言要自負法律責任,相關案例層出不窮,請慎重發文!