我們都習慣把修圖稱為P圖、或是PS圖,主要指的當然是透過Photoshop來進行各種神奇的應用。不過,讓我們來看看以下這段Demo,你會發現,修圖從來沒有這麼簡單過,相比之下Photoshop像是上個世紀的老古董。

原來,現在P圖真的只需要輕輕點兩下,AI就能徹底理解你的想法!

小到豎起狗狗的耳朵:

大到讓整隻狗蹲下來,甚至讓馬岔開腿跑步,都只需要設定一個起始點和結束點,外加拽一拽就能搞定:

不止是動物的調整,連像汽車這樣的非生物,也能一鍵拉升底座,甚至升級成加長豪華車:

這還只是AI修圖的基本。

要是想對圖像實現更精準的控制,只需畫個圈給指定區域“塗白”,就能讓狗狗轉個頭看向你:

甚至是讓獅子張大嘴,連「牙齒」這種素材圖片都不需要、分什麼圖層?那都是上個世紀的事情了!你只要讓他嘴巴打開,AI自動就能給它安上:

如此有手就能做的修圖神器,來自一個MIT、Google、馬普所等機構聯手打造的DragGAN新模型,論文已入選SIGGRAPH 2023。

沒錯,在擴散模型獨領風騷的時代,竟然還能有人把GAN玩出新花樣!

目前這個專案在GitHub上已經有5k+ Star,熱度還在不斷上漲中(儘管一行程式碼還沒發)。

所以,DragGAN模型究竟長啥樣?它又如何實現上述神一般的操作?

DragGAN:拽一拽關鍵點,就能修改圖像細節

這個名叫DragGAN的模型,本質上是為各種GAN開發的一種互動式圖像操作方法。

論文以StyleGAN2架構為基礎,實現了點點滑鼠、拽一拽關鍵點就能P圖的效果。

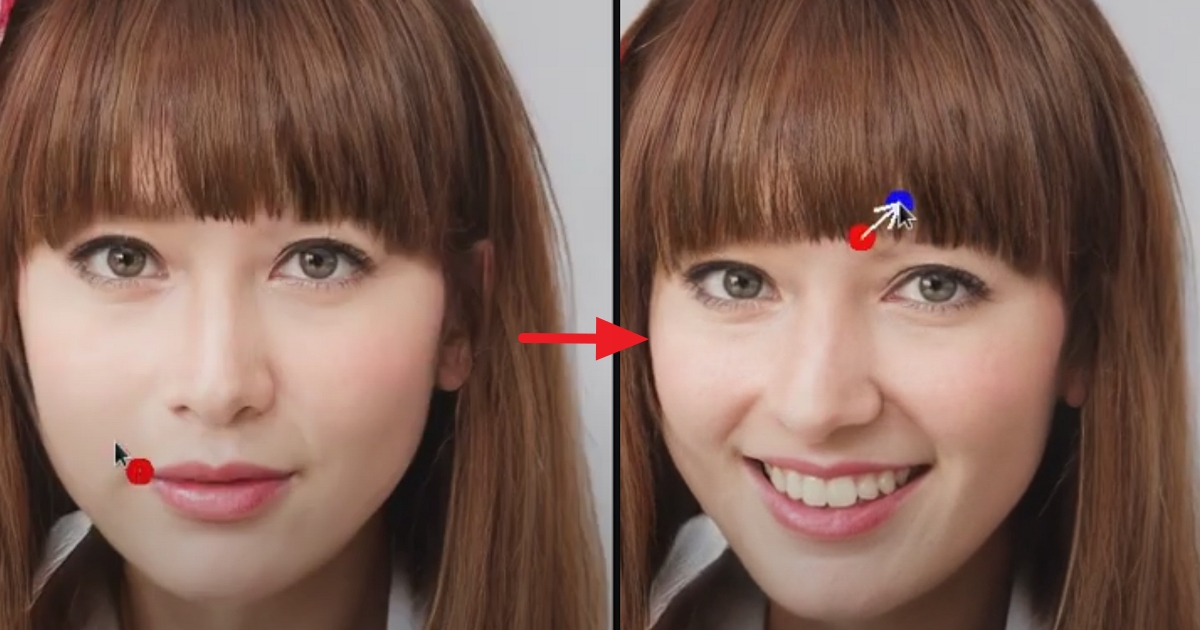

具體而言,給定StyleGAN2生成的一張圖像,使用者只需要設定幾個控制點(紅點)和目標點(藍點),以及圈出將要移動的區域(比如狗轉頭,就圈狗頭)。

然後模型就將迭代執行運動監督和點跟蹤這兩個步驟,其中運動監督會驅動紅色的控制點向藍色的目標點移動,點跟蹤則用於更新控制點來跟蹤圖像中的被修改對象。

這個過程一直持續到控制點到達它們對應的目標點。不錯,運動監督和點跟蹤就是我們今天要講的重點,它是DragGAN模型中最主要的兩個元件。

先說運動監督。在此之前,業界還沒有太多關於如何監督GAN生成圖像的點運動的研究。在這項研究中,作者提出了一種不依賴於任何額外神經網路的運動監督損失(loss)。

其關鍵思想是,生成器的中間特徵具有很強的鑑別能力,因此一個簡單的損失就足以監督運動。

所以,DragGAN的運動監督是通過生成器特徵圖上的偏移補丁損失(shifted patch loss)來實現的。

如下圖所示,要移動控制點p到目標點t,就要監督p點周圍的一小塊patch(紅圈)向前移動的一小步(藍圈)。

再看點跟蹤。

先前的運動監督會產生一個新的latent code、一個新特徵圖和新圖像。由於運動監督步驟不容易提供控制點的精確新位置,因此我們的目標是更新每個手把點p使其跟蹤上對象上的對應點。

此前,點跟蹤通常通過光流估計模型或粒子視訊方法實現。但同樣,這些額外的模型可能會嚴重影響效率,並且在GAN模型中存在偽影的情況下可能使模型遭受累積誤差。

因此,作者提供了一種新方法,該方法通過最近鄰檢索在相同的特徵空間上進行點跟蹤。

而這主要是因為GAN模型的判別特徵可以很好地捕捉到密集對應關係。

基於這以上兩大元件,DragGAN就能通過精確控制像素的位置,來操縱不同類別的對象完成姿勢、形狀、佈局等方面的變形。

作者表示,由於這些變形都是在GAN學習的圖像流形上進行的,它遵從底層的目標結構,因此面對一些複雜的任務(比如有遮擋),DragGAN也能產生逼真的輸出。

單張3090幾秒鐘出圖

所以,要實現幾秒鐘精準控圖的效果,是否需要巨大的算力?

no~no~no~大部分情況下,每一步拖曳修圖,單張RTX 3090 GPU在數秒鐘內就能搞定。具體到生成圖像的效果上,實際評估(均方誤差MSE、感知損失LPIPS)也超越了一系列類似的AI修圖模型,包括RAFT和PIPs等等:

值得一提的是,DragGAN的潛力還不止於此。

一方面,如果增加關鍵點的數量,還能實現更加精細的AI修圖效果,用在人臉這類對修圖要求比較嚴格的照片上,也是完全沒問題:

另一方面,不止開頭展示的人物和動物,放在汽車、細胞、風景和天氣等不同類型的圖像上,DragGAN也都能精修搞定。

除了不同的照片類型,從站到坐、從直立到跑步、從跨站到並腿站立這種姿勢變動較大的圖像,也能通過DragGAN實現:

不過,也有網友指出了DragGAN目前面臨的一些問題。

例如,由於它是基於StyleGAN2生成的圖像進行P圖的,而後者訓練成本很高,因此距離真正商業落地可能還有一段距離。

除此之外,在論文中提到的“單卡幾秒鐘修圖”的效果,主要還是基於256×256解析度圖像:

至於模型是否能擴展到256×256以外圖像,生成的效果又是如何,都還是未知數。

有網友表示至少高解析度圖像從生成時間來看,肯定還要更長。

實際上手的效果究竟如何,我們可以等6月論文程式碼開源後,一測見真章。

是時候給自己的首頁照片修圖了。

論文網址:https://vcai.mpi-inf.mpg.de/projects/DragGAN/data/paper.pdf

專案地址(程式碼6月開源):https://github.com/XingangPan/DragGAN

參考連結:

[1]https://weibo.com/1727858283/N1iKl4zVG

[2]https://twitter.com/_akhaliq/status/1659424744490377217

[3]https://twitter.com/mrgreen/status/1659482594516377601

本文轉載自量子位

請注意!留言要自負法律責任,相關案例層出不窮,請慎重發文!