2011年,Google開發了一個可以辨識YouTube影片中的貓的系統,隨後不久便出現了一波基於DNN的分類系統。但AI研究人員知道DNN實際上並不瞭解世界。它們只是由許多數位神經元組成的,分佈在許多上下相互連接的各層網路中的,類似大腦結構的鬆散模型。

假設一輛自動駕駛汽車看到停車標誌時並沒有減速,而是加速駛入了繁忙的十字路口,從而導致了交通事故。事故報告顯示,停車標誌的表面黏了四個小的矩形標誌。這說明一些微小擾動就能愚弄車載人工智慧(AI),使其將「停止」一詞誤讀為「限速45」。

目前,此類事件還未發生,但是人為擾動可能影響AI是非常現實的。研究人員已經展示了如何透過黏貼紙來欺騙AI系統誤判停車標誌,或者透過在眼鏡或帽子上黏貼印刷圖案來欺騙人臉辨識系統,又或者透過在音訊中插入白噪聲使語音辨識系統產生錯誤判斷。

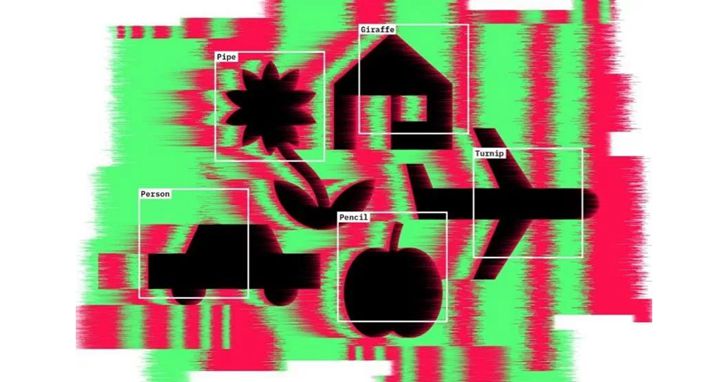

這只是一些攻擊AI中領先的模式辨識技術——深度神經網路(DNN)的小示例。事實證明,這些方法在正確分類各種輸入方面(包括圖像、語音和有關消費者偏好的數據)非常成功。從自動電話系統到串流媒體服務Netflix上的使用者推薦,這都是日常生活中的一部分。對輸入進行人類難以察覺的微小更改,就能使周圍最好的神經網路發生混淆。

加利福尼亞大學柏克萊分校電腦科學博士生Dan Hendrycks表示,在這種不完美的技術中,這些問題比特殊的怪癖更麻煩。像許多科學家一樣,他一開始也認為其是DNN的內在缺陷:在訓練領域能出色地完成任務,但是一旦進入陌生領域,就會因為各種原因而失效。

這可能會導致嚴重的問題。越來越多的深度學習系統從實驗室走向現實世界,從自動駕駛汽車到犯罪測量和診斷疾病。但是,今年一項研究報告稱,惡意添加到醫學掃瞄中的圖像可能會使DNN誤檢測癌症。另一方面,駭客可以利用這些弱點駭掉一個線上AI系統,從而執行自己的程式碼。

努力尋找問題根源的過程中,研究人員發現了許多DNN失敗的原因。位於加利福尼亞山景城的Google的AI工程師François Chollet認為,「DNN的內在缺陷是沒有解決辦法的。要克服這些缺陷,研究人員需要開發額外的功能來增強模式匹配DNN,例如,使AI能夠自己探索世界,自己寫程式碼並保留記憶。「一些專家認為,這將是未來十年AI的研究方向。

現實檢驗

2011年,Google開發了一個可以辨識YouTube影片中的貓的系統,隨後不久便出現了一波基於DNN的分類系統。加州舊金山Uber AI Labs的高級研究經理,懷俄明大學拉拉米分校的傑夫‧克勞恩(Jeff Clune)表示,不明就裡的人都在說,「哇,這太神奇了,電腦終於可以理解世界了」。

但只有AI研究人員知道DNN實際上並不瞭解世界。它們只是由許多數位神經元組成的,分佈在許多上下相互連接的各層網路中的,類似大腦結構的鬆散模型。

其思想是,原始輸入進入底層的特徵(例如圖像中的像素)會觸發其中一些神經元,然後根據簡單的數學規則將訊號傳遞到上一層的神經元,每次調整神經元的連接方式,訓練DNN網路涉及到將其暴露於大量示例中,以便最終頂層可以提供所需的答案。例如,即使DNN之前從未看到過該圖片,也能始終將獅子的圖片輸出為獅子。

2013年,Google研究員Christian Szegedy和他的同事發佈了一份名為「神經網路的有趣特性」的預印本,這是對神經網路在現實應用的第一次檢驗。以獅子的圖像為例,即使改變一些像素,例如在圖像裡添加圖書館背景,DNN能確認它看到了不同的內容,但是依然能辨識圖中的獅子。小組稱篡改的圖像為「對抗樣本」。

- 資料來源:Why deep-learning AIs are so easy to fool

- 本文授權轉載自大數據文摘

請注意!留言要自負法律責任,相關案例層出不窮,請慎重發文!