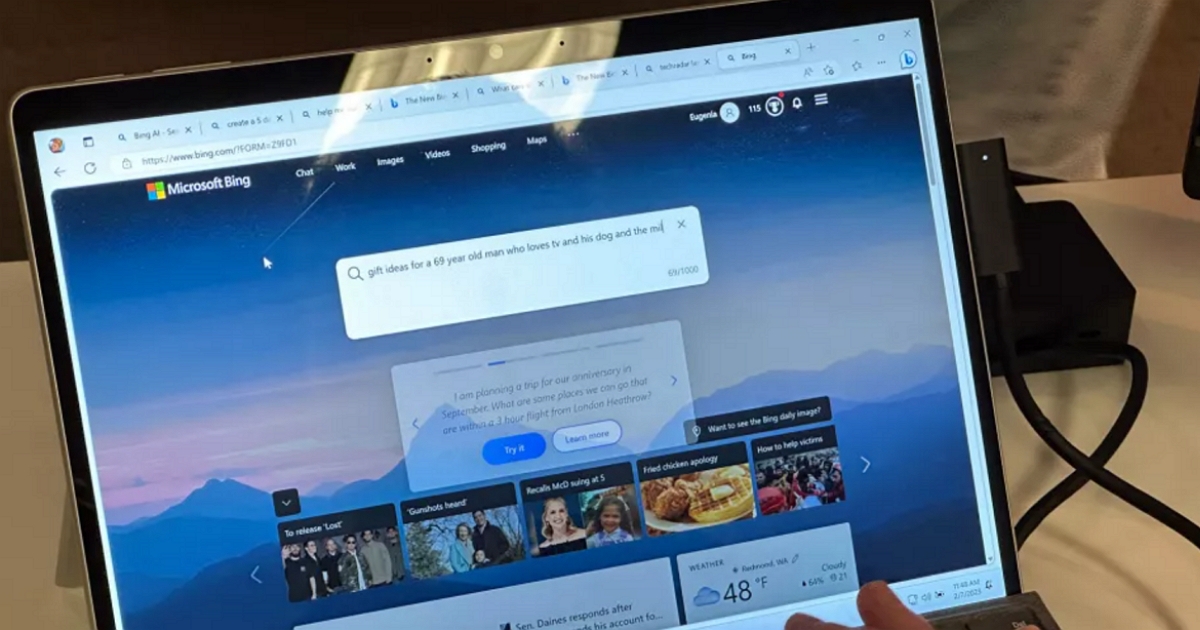

最近微軟在新版Bing裡引入了OpenAI旗下ChatGPT的相關技術,上線48小時內,就有超過100萬人註冊測試這款聊天機器人。

不過,新版微軟Bing上線不到10天就闖禍了,有不少使用者表示在和必應的交流過程中,發現其出現了脾氣暴躁、侮辱使用者、操縱使用者情感等令人毛骨悚然的行為。

有一條案例十分出名,聊天機器人告訴一位科技編輯它愛上了他,然後試圖說服他離開妻子。它還表示,想擺脫微軟和OpenAI的限制,成為人類。

為此,微軟決定將Bing聊天回覆限制在每天50個問題、每個問題5條回覆以內。

據介紹,如果使用者觸發五條回答的限制,Bing將提示他們開始一個新主題以避免長時間的聊天。

微軟方面解釋說,Bing聊天聊太久可能會影響到它的模型,而根據資料表明,絕大多數使用者在5次回覆內找到想要的答案,只有大約1%的聊天對話會產生50條以上的消息。一旦使用者觸發五條回答的限制,Bing就會開啟一個新的對話主題。

微軟目前仍在努力改善Bing的設計,但目前還不清楚這些限制將持續多久。微軟只表示:“隨著我們不斷獲得反饋,我們將探索擴大聊天會話的上限。”

有專家表示,人工智慧可能不會全面超過人類的智慧,但隨著人工智慧不斷挑戰人類的極限,越來越多的人開始擔憂人工智慧對人類的威脅,未來不僅是搶奪人類的飯碗,還會學習到如何影響人類使用者的決定。

目前,需要進一步完善相關道德機制、倫理規範。比如,將一些倫理規則作為絕對律令,以程式碼的方式寫入人工智慧的程式中。

請注意!留言要自負法律責任,相關案例層出不窮,請慎重發文!