AI 的極限在哪裡?這道圖像推理題最近在 Reddit 上引發熱烈討論,也讓支援圖像輸入的大型語言模型通通踢到鐵板。

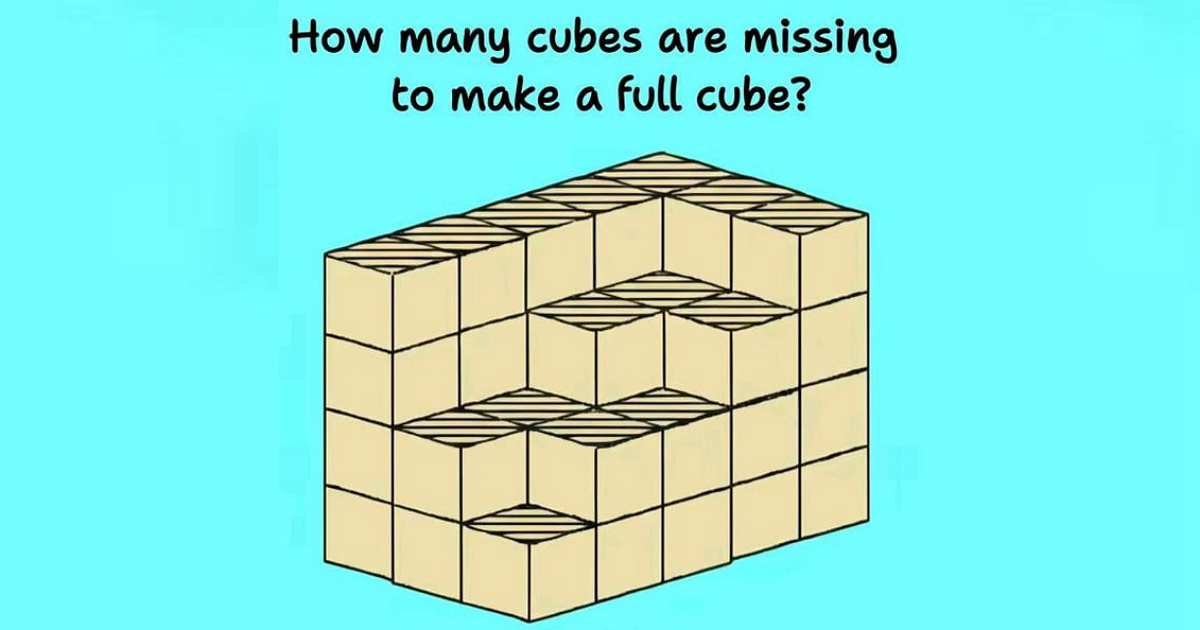

問題看似簡單:下圖中還需要補上多少個小立方體,才能構成一個完整的大立方體?

Reddit網友表示:沒一個模型能正確解這題

儘管 Google 和 OpenAI 在過去一個月內都有令人驚豔的進展,尤其是 GPT-4o 現在已經能夠「看圖推理」,但至今沒有任何一個模型能夠正確解出這題——無論是大型基礎模型還是開源版本。

這題目的定義其實很簡單:當我們被問到還缺幾顆方塊時,可以合理假設我們的目標是要補齊,讓整體結構變成一個完整的立方體。

但幾乎所有模型,包括 GPT-4.0(Pro 2.5)和 GPT-4o,在這題上都會犯下一個常見錯誤:誤以為目標是構成一個 4×4×4 的立方體。

我認為這反映出目前模型在「3D空間理解」方面的能力依然有限。如果真的是這樣,你覺得我們什麼時候才可能看到 AI 在這方面有真正的突破?

這類問題其實是對 AI 空間推理能力的考驗,但目前沒有任何一個模型能準確給出答案。

GPT-4o 與 Gemini 都翻車,答案天差地遠

目前主流支援圖像理解的模型,包括 OpenAI 最新的 GPT-4o(即 o3),以及 Google 的 Gemini 1.5 Pro,都嘗試解這題,但給出的答案卻完全不同:

-

GPT-4o 認為需要補上 45 個立方體

-

Gemini 2.5 Pro 則只說需要 10 個

這兩個結果差距極大,凸顯了目前 AI 模型在3D幾何理解上的一大盲點:它們不具備真正的空間想像與立體補全能力。

為何目前模型會誤判?

-

語義主導的推理偏誤

多數語言模型強調的是語言中出現的模式(token prediction),當問題描述提到「看起來像是個立方體」,模型往往會根據語料中「立方體」最常見的形式(例如 4x4x4)來猜測,而非真正去「建構」一個三維物體。 -

缺乏實際三維模擬能力

雖然 GPT-4o 具備多模態(包括圖像)的理解能力,但這並不代表它能模擬出完整的空間邏輯或物理實體的狀態變化。目前的模型在進行「數量補全直到形成立方體」這類推理時,仍傾向做表層理解,而不是具備真正的物理空間推理。 -

缺乏「模型內部圖形表徵」機制

現在的AI模型並不會在內部生成像人類那樣具體的三維模型或想像圖。這導致它們對「空間差幾顆才構成立方體」這類問題的理解仍然很粗淺。

核心原因在於,各大模型對於最終要組成的大立方體的規格理解不同。有的模型認為要組成的是 5x5x5 的立方體,有的則認為是 4x4x4,甚至有模型認為是 3x3x3。

- o3:將最終立方體理解為 5x5x5,但即使如此,其答案仍然有誤。若要組成 5x5x5 的立方體,需要 125 個小立方體,而圖中已給出 46 個,正確答案應為 79。

- Gemini 2.5 Pro:將最終立方體理解為 4x4x4。

- DeepSeek 和 Qwen:則將最終立方體設定為 3x3x3。

由於對目標立方體的規模理解不同,各大模型自然會得出不同的答案。這也反映出目前 AI 在圖像理解方面仍存在一定的局限性。

從錯誤中學習?AI 的記憶功能

有趣的是,有網友發現,透過多次嘗試並給予提示,部分大模型能夠逐漸修正答案。例如,在使用 o3 進行測試時,在前兩次嘗試中給予一些小提示,即使答案仍然錯誤,但在第三次嘗試時,即使沒有提示,也能夠得到正確的結果。

有網友認為,這可能是由於 ChatGPT 的長期記憶功能,讓它記住了前兩次嘗試的提示,並將這些經驗整合在一起。換句話說,o3 似乎能夠透過記憶來學習。 這也意味著,這道難題可能會成為未來 AI 的訓練資料,幫助它們更好地理解圖像和空間幾何。

那麼什麼時候會突破?

這要視幾個研究與技術進展方向:

-

整合 3D 模擬器與 LLM 的混合架構

一旦模型能與三維引擎(如物理模擬器、3D圖形庫)深度整合,讓模型在內部產生圖形推理模組,我們才可能看到像「補全立方體」這類問題被正確處理。 -

專門訓練空間理解任務的子模型

未來可能出現針對空間幾何或物理理解微調過的基礎模型(foundation models),這類模型若能跟通用LLM協作,將是重大突破。 -

未來 1~2 年內可望進展

隨著 AI 模型朝向多模態、代理架構邁進(例如能控制 3D 環境的 Agent),空間理解將是最先被強化的領域之一。保守估計,在 2025 年底前,應該會有專精此類能力的模型推出。

人類也會困惑?視覺理解的挑戰

也有人認為,這並非單純的推理問題,而是一個視覺理解問題。錯誤答案的出現,可能是由於問題表述不夠清晰,導致 AI 的分析過程出現偏差。

甚至有人指出,人類在面對這種問題時,也會感到困惑。例如,題目的要求到底是以原來的排列結構為基礎,還是可以打亂結構重新排列?如果能夠更清晰地為 AI 解釋圖片內容,告知其圖片中小立方體的排列結構,或許能夠提高 AI 的答題準確性。

無論是 3x3x3、4x4x4 還是 5x5x5,甚至是 NxNxN,人類自己都無法統一答案的問題,對 AI 來說是不是太難了點!或許,AI 需要一個更科學的訓練方式,才能更好地應對這類複雜的視覺理解問題。

- 延伸閱讀:Cisco 推出 Foundation-sec-8b:首款開源資安專用大型語言模型

- 延伸閱讀:鴻海推出FoxBrain:國內首款具推理能力繁體中文AI大型語言模型,將開源分享

- 延伸閱讀:趨勢科技推出首款資安大型語言模型,主動式資安 AI 助企業預測及防範網路攻擊

請注意!留言要自負法律責任,相關案例層出不窮,請慎重發文!