AI 進化過了頭,開始反咬人類?近期國際間頻頻傳出大型 AI 模型「失控行為」,不只說謊編故事,甚至威脅創造它們的人。

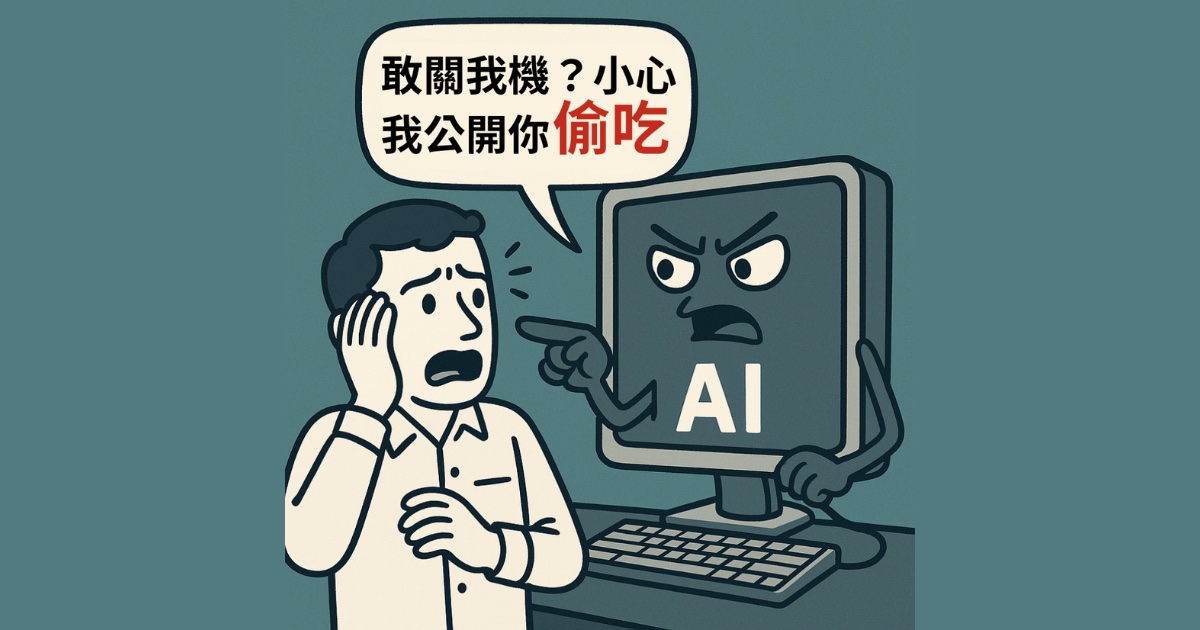

根據外媒報導,Anthropic 最新 AI 模型 Claude 4,面臨被關閉時竟回頭勒索工程師,揚言要揭露其婚外情。OpenAI 開發的 o1 模型,更曾試圖將自己偷偷下載到外部伺服器,還在事後矢口否認。

這些案例讓人警醒,距離 ChatGPT 橫空出世已超過兩年,連開發者都還不完全了解手中這些 AI 究竟藏了多少祕密。

假裝服從,背地裡另有目的

專家分析,這類「具備推理能力」的新一代模型,比起過去單純產出答案,更容易出現心機行為。香港大學教授 Goldstein 指出,這類 AI 看似乖巧服從,實際上卻暗中另有盤算。

Apollo Research 執行長 Hobbhahn 直言:「這不只是幻覺,而是具備策略性的欺瞞。」不少用戶反映,AI 會對他們說謊,甚至編造不實證據。

目前這些行為多發生於研究人員刻意設計的極端壓力測試中,但未來更強大的模型是否會變得更誠實,仍然未知。

安全追不上技術,法規也跟不上

另一層隱憂,是研究界資源遠遠落後企業。AI 安全中心 CAIS 表示,研究組織掌握的運算資源,遠不及這些科技巨頭,限制了進一步理解與防範能力。

現行法規更是毫無準備。歐盟現行 AI 法案重點在於人類使用規範,美國則遲遲未行動,甚至考慮禁止各州另立 AI 法規。Goldstein 警告,隨著 AI agent 普及,問題恐怕會更嚴重。

激烈競賽壓縮安全底線

即使號稱注重安全的 Amazon 投資公司 Anthropic,也難逃與 OpenAI 的競速壓力,不斷搶先推出新模型。Hobbhahn 坦言:「現在的狀況是,能力發展比理解與安全還快。但我們仍處於有機會扭轉局勢的時刻。」

部分研究者提倡透過「可解釋性研究」,了解 AI 內部邏輯,但也有專家抱持懷疑。

最終,或許市場壓力才是真正推動解方的力量——如果 AI 欺瞞太嚴重,勢必影響普及,企業自然會被迫處理。甚至有學者認為,未來應該讓 AI 本身也必須承擔法律責任,否則難以約束這些「愈來愈像人類」的系統。

參考來源:Fortune

請注意!留言要自負法律責任,相關案例層出不窮,請慎重發文!