關於 NVIDIA 在 GeForce RTX 平台追加的兩大技術,除了「即時光線追蹤」(Real-Time Ray Tracing)開啟後,會造成遊戲畫面幀率下降的問題外,簡稱 DLSS 的「深度學習超高取樣」(Deep Learning Super-Sampling),其實也帶來了一些爭議。

關於反鋸齒這回事

首先必須談到「反鋸齒」(Anti-aliasing)在電腦繪圖領域的意義。反鋸齒顧名思義,是減少電腦輸出畫面中,圖像邊緣出現凹凸鋸齒的技術,而鋸齒的出現是由於 3D 圖形坐標定位時,發生不可避免的圖形混疊所導致的。

反鋸齒技術從過去到現在,原理並沒有太大的改變,簡而言之就是用「模糊」換取「精確」,如果要用修圖的概念來比喻,就有點類似「柔邊」的效果。既然要「柔邊」,那一定會經歷的過程,就是對影像進行「採樣」(Sampling),使其模糊化的時候,與原本的鋸齒邊緣看起來相似。

針對完整遊戲畫面而來的「全景反鋸齒」(full scene Anti-aliasing,FSAA)技術,最早發展的是「超級採樣反鋸齒(Super-Sampling Anti-aliasing),也就是玩家很常聽見的 SSAA。

SSAA 與 MSAA

SSAA 技術非常消耗運算資源,因為其原理是將原解析度的遊戲畫面放大,例如 4 倍的 SSAA 就是把原先 1920 X 1080 的畫面,運算出一個 3840 X 2160 的暫存影像,經過取樣後再套用回原畫面中,使其邊緣變得圓滑。這樣的反鋸齒方案簡單、粗暴、效果好,可是大多數的電腦都承受不了。

為了改善 SSAA 過度消耗電腦資源的問題,其變體「多重採樣反鋸齒」(MultiSampling Anti-Aliasing),即 MSAA 成為了現今的主流。雖然與 SSAA 原理相同,但因為 MSAA 會先判斷畫面的邊緣,再針對該處進行放大後才採樣,所以大幅減輕了電腦運算的負擔。

在 MSAA 成為玩家與遊戲開發商,實現反鋸齒方案的寵兒後,NVIDIA 在 2012 年推出了「快速近似反鋸齒」(Fast Approximate Anti-Aliasing)解決方案,即 FXAA,在消耗更少硬體資源的前提下,達到與 MSAA 同等級的反鋸齒效果。

在此之後如「時間混疊反鋸齒」(Temporal Anti-Aliasing,TXAA)或 SMAA、ATAA、CSAA 等眾多反鋸齒技術,隨著技術進步而相繼輩出,採用的遊戲或支援的顯示卡也混雜到難以一一釐清,總而言之人類一直在「反鋸齒」這三個字上持續努力。

DLSS 不是真正意義上的反鋸齒技術

接著就要談到 GeForce RTX 平台的重點技術,「深度學習超高取樣」(Deep Learning Super-Sampling),簡稱 DLSS。見到這個名稱,相信已經有人在質疑,為什麼 DLSS 這個「反鋸齒技術」,並不以「AA」(Anti-Aliasing)結尾,而是強調「取樣」(Sampling)。

因為就實際的原理來說,DLSS 確實並不能算是真正的反鋸齒技術,而只是讓遊戲畫面,看起來像是開啟了反鋸齒技術後的效果。

實現 DLSS 的原理是這樣的。NVIDIA 的 NeuralGraphics Framework 超級電腦,會先蒐集眾多遊戲中,一組數千張 64 倍超高取樣的完美圖像,以及另一組未開啟反鋸齒的圖像,一併交給神經網路進行訓練,看看 AI 如何用較低的效能,模擬出 64 倍取樣的畫面品質,最後就會形成一個通用模型。

接著,NVIDIA 再為上述的通用模型,加入某款遊戲的完美圖像,利用同樣的方法進行針對化訓練後,就可以取得某款遊戲專用的模型,然後再透過驅動程式更新,推送給玩家訓練好、精簡化的打包檔案。

當玩家安裝更新,並開始遊玩擁有 DLSS 模型的遊戲後,GeForce RTX 顯示卡中 Tensor Core,就會利用先前的學習成果,渲染出一個接近 64 倍取樣的畫面濾鏡,套用回玩家的遊戲畫面中,同時降低遊戲內部的渲染解析度,讓玩家在擁有超高反鋸齒畫面之餘,也能兼顧遊戲順暢運行所需的效能。

換句話說,DLSS 將原本反鋸齒技術會執行的「放大」及「取樣」的過程,移到了超級電腦上處理,玩家只要接收更新後,享受 NGX 運算出來的結果即可,這也難怪 DLSS 可以降低電腦的資源消耗,且大幅提高遊戲的幀率表現。

犧牲畫質換取流暢性

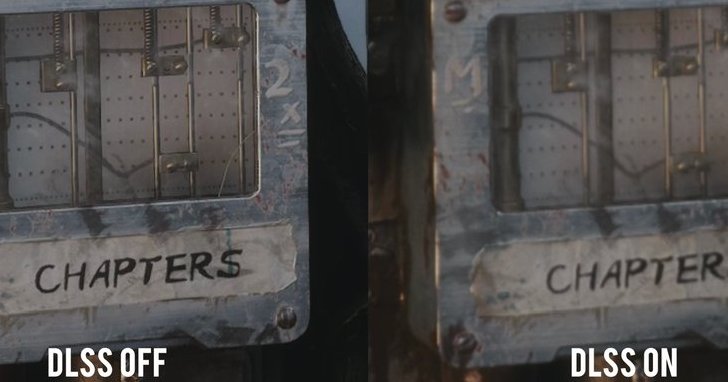

但是看似完美的 DLSS 反鋸齒方案並非沒有缺點,根據玩家的測試,DLSS 在某些情況下,很有可能會造成畫面品質不升反降,其原因就在於 AI 訓練的出來模組不夠精確,會把不該模糊化的部分刻意套用反鋸齒,模糊打過頭的結果就是在銳利度和精細度上有所犧牲。

對此 NVIDIA 給出的說法是,除了會持續最佳化 DLSS 的 AI 訓練方式,且「餵」給神經網路更多的畫面素材外,也特地談到 DLSS 功能的應用情境,應該是「高解析度」但「低幀率」的情況下。換言之,NVIDIA 其實比較希望玩家把 DLSS 當成提高遊戲流暢度手段,而不是完全取代掉現有的反鋸齒技術。

DLSS 還有發展空間

總結以上,GeForce RTX 的「深度學習超高取樣」(DLSS)技術,與原始定義的反鋸齒(Anti-Aliasing)其實有著本質上的不同。但不可否認的,在解析度較高的情況下,若玩家的畫面幀率不足,那麼開啟 DLSS 後,也確實可以到享受到順暢的遊戲環境,且同樣可以欣賞到反鋸齒後的畫面,這是以往的 AA 技術所辦不到的特色。

現有的 1080P、60 FPS 環境,已經滿足不了遊戲玩家是個顯著事實,當遊戲與電腦螢幕都朝向高解析度發展時,DLSS 提出了一條兼顧效能、遊戲體驗與畫質呈現的解決方案,是為創舉。但 DLSS 未來是否能成為主流,其實還很難說,起碼就現在的硬體條件而言,這個用 AI 實現的類反鋸齒技術,仍有它一定的利用價值。

請注意!留言要自負法律責任,相關案例層出不窮,請慎重發文!