近期,南韓高等科學技術院(KAIST)與TB級互聯與封裝實驗室(TERA Lab)共同預測未來十年內AI GPU加速卡及高頻寬記憶體(HBM)的發展趨勢,部分數據之誇張程度,讓人不禁質疑「真的走得下去嗎?」

目前最先進的HBM技術是HBM3E,NVIDIA B300系列、AMD MI350系列的配置容量最高達288GB。而接下來的HBM4世代,預計NVIDIA Rubin系列將支援到384GB,AMD MI400系列則挑戰432GB。

再往後的標準尚未定案,但預估HBM5可達400~500GB,HBM6則可能推升至1.5~1.9TB(1536~1920GB),甚至HBM7更可能突破至4.2~6TB(5120~6144GB)!

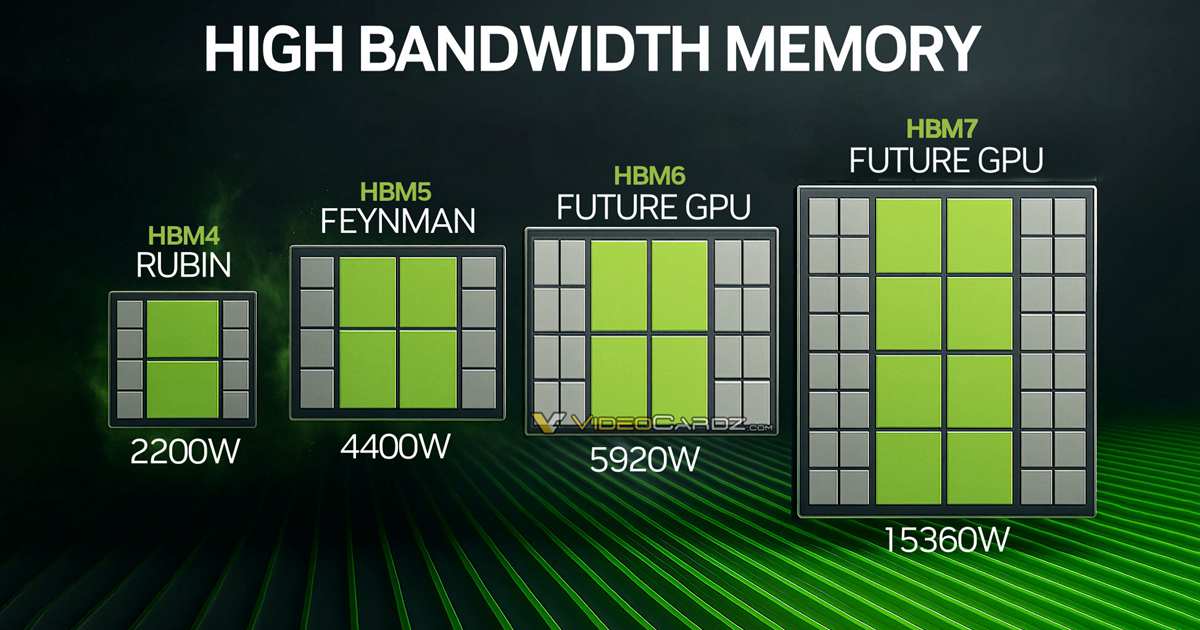

據傳,NVIDIA Rubin將於明年登場,晶片面積達728平方毫米,單顆功耗高達800W,雙晶片封裝後的整體功耗可能達2200W,搭配8顆HBM4記憶體,總頻寬達32TB/s。

目前AMD MI350系列的風冷版本已達1000W,水冷版更達1400W,NVIDIA B300也不遑多讓,功耗同樣衝到1400W。

接著是預計2029年推出、代號Feyman的下一代NVIDIA AI GPU。根據推測,其單顆功耗將達900W,採四晶片整合封裝,整卡面積高達4800平方毫米,搭配8顆HBM5、帶寬達48TB/s,整卡總功耗預估會達到驚人的4400W。

未來還有更激進的規格預測——2032年將問世的新一代GPU,單晶片面積雖縮小為700平方毫米,但單顆功耗突破1000W,搭載16顆HBM6、總帶寬256TB/s,整卡功耗可能高達6000W!

最誇張的是2035年預估推出的新架構:單晶片面積進一步縮至600平方毫米,單顆功耗達1200W,並首度採用八晶片封裝,中介層面積超過9000平方毫米,搭配32顆HBM7,帶寬可達1TB/s,整卡功耗竟高達15,000W!

這樣下去,難道每座資料中心旁都得興建一座核電廠來供電?AI的進化之路,恐怕也得先面對能源的極限。

- 延伸閱讀:OpenAI 揭秘 GPT-4.5 研發全過程:10 萬張 GPU 叢集啟動,內部曾陷「災難性錯誤」

- 延伸閱讀:Grok AI背後的超級電腦細節曝光:已投資29億台幣,百萬枚GPU面臨當地電力供應不足問題

請注意!留言要自負法律責任,相關案例層出不窮,請慎重發文!