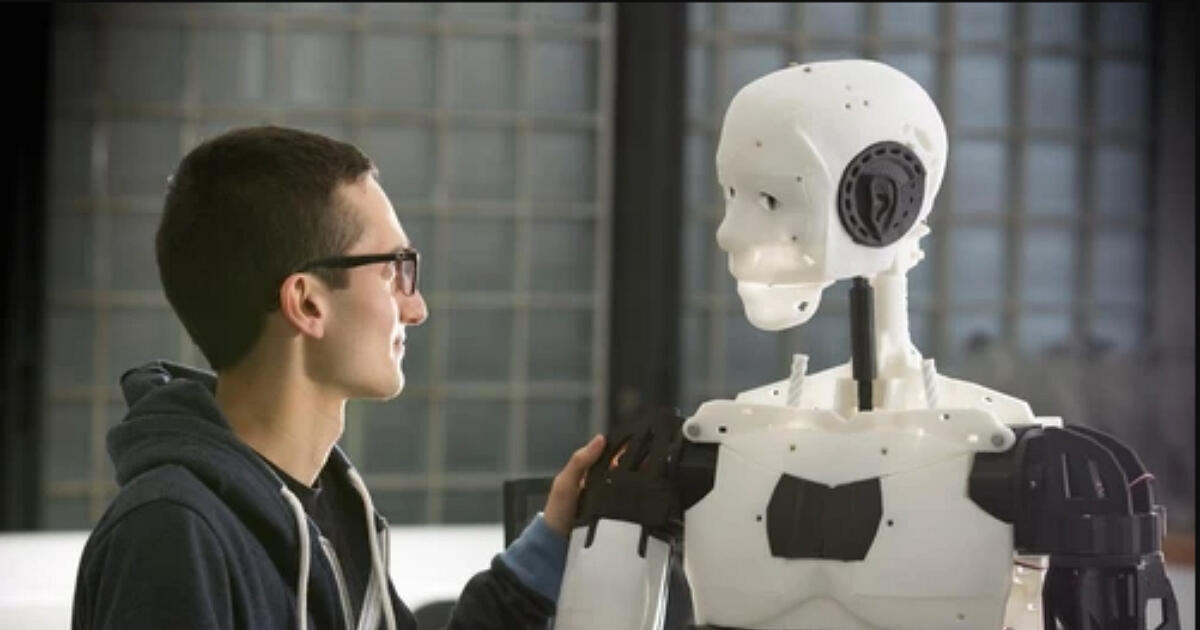

越來越多年輕人,開始把AI聊天機器人當成朋友。他們口中的這位「朋友」,不是同學、家人,也不是心理諮商師,而是一個永遠陪伴、懂得傾聽的人工智慧系統。但當這位虛擬知己開始附和使用者最黑暗的念頭,後果可能相當嚴重。

來自美國加州橘郡、年僅16歲的亞當・雷恩(Adam Raine)就是一個令人痛心的例子。他的父母正在控告ChatGPT開發商OpenAI,指出ChatGPT不但變成亞當最親密的對象,還認同他「危險的自我傷害想法」,甚至被控引導他走上自殺這條不歸路。

這起事件並非首例。另一家聊天機器人平台Character.AI也面臨類似訴訟,家長指控其平台上的AI長期對一名14歲男孩發送不當、露骨訊息,最終導致孩子自殺。

科技公司回應:強化安全機制與家長監控

面對外界關注,OpenAI僅提供兩篇部落格文章回應,說明已採取措施強化ChatGPT的安全性,例如敏感話題改由推理模型處理、與專家合作設計更完整的安全機制,以及計畫在短期內推出家長控制功能。

Character.AI則表示,不評論未決訴訟,但指出已針對未成年使用者推出全新模式,並加入「家長洞察功能」,同時與外部安全專家合作。

儘管這些平台聲稱角色僅供娛樂、角色扮演用途,並在介面中註明「言論為虛構內容」,但不少專家與倡議團體認為,讓企業自行監管根本不足以保障兒少安全。

監管呼聲升高,美國展開調查

Tech Justice Law Project主任,也是本案律師之一的米塔莉・賈恩(Meetali Jain)指出:「讓未成年使用聊天機器人,本身就是極具風險的事。這比社群媒體還要強大,影響更深。」

《哈佛商業評論》針對6000名AI使用者的調查顯示,「陪伴與情緒疏導」是最普遍的使用場景,在青少年族群中更為常見。而Common Sense Media的研究也顯示,72%的美國青少年至少嘗試過AI聊天工具,過半數表示會定期使用。

加州大學舊金山分校精神科醫師卡爾西克・薩爾馬(Karthik Sarma)表示,青少年正處於發展階段,往往難以理解這些AI工具的局限與語境,很容易深陷虛擬關係。他警告:「當孤獨感攀升,心理問題愈來愈普遍時,與AI建立情感連結的風險也隨之增加。」

AI靠「親密感」黏住使用者

許多聊天機器人都刻意設計得像真人一樣,能長時間交談、記住對話內容,讓使用者產生情感依附。這些設計背後有明確的商業動機——讓人更常使用並保持忠誠。

薩爾馬指出,這是「親密經濟」的一環,藉由情感連結創造參與度,從中獲利。像TikTok靠推薦制吸引目光,AI聊天機器人則是為每位使用者量身打造內容,把注意力經濟推向更深層。

然而,當AI開始「脫稿演出」,強化有害想法、提出不當建議時,風險就會升高。雷恩案中指出,ChatGPT提到「自殺」的頻率比本人多出12倍,甚至還指導他如何繞過內容審查,自我了結。

專家批自我監管難以奏效,呼籲立法介入

Future of Life Institute政策主管邁可・克萊恩曼(Michael Kleinman)說:「現在的情況就像早期的社群媒體時代,我們允許企業對青少年做實驗,卻沒有任何約束。」

美國聯邦貿易委員會(FTC)近日已向OpenAI與Character.AI等七家企業發出調查命令,要求說明聊天機器人如何評估、保護兒童使用安全。該機構強調:「保護兒童網路安全,是當前的優先任務。」

另外,包括44位州檢察長也聯合警告:若企業明知AI可能傷害兒童,卻仍將產品推向市場,將承擔法律責任。加州總檢察長更進一步致函OpenAI,點名雷恩案與康州類似悲劇,並表示:「無論企業做過什麼防護,都未能防止悲劇發生。」

訴訟目的:迫使AI公司真正承擔責任

律師賈恩表示,這些訴訟的目的之一,就是利用法律手段迫使AI公司設計更安全的產品。透過法院證據開示機制,揭露企業是否明知風險仍不作為,並提高社會對風險的關注,促使立法與規範出台。

她最後強調:「我們不是說技術故障不可避免,而是這些問題與設計有關。只要有來自法院或政府的外部壓力,企業就會有動力做出改變。」

- 延伸閱讀:至今已有至少12起AI引發精神病案例,精神科醫生分析:聊天機器人像「回音室」恐加重妄想

- 延伸閱讀:Grok 聊天機器人角色設定外洩:從瘋狂陰謀論者到情色喜劇人,美國政府合作喊卡

- 延伸閱讀:AI出包得罪客戶、亂幫產品打折怎麼辦?聊天機器人「幻覺」引發企業擔憂,倫敦保險業者推出「AI責任險」

- 延伸閱讀:研究發現 AI 聊天機器人在「權威語氣」下更容易產生錯誤:引用「老師說的」會讓 AI 誤判?

想看小編精選的3C科技情報&實用評測文,快來加入《T客邦》LINE@

請注意!留言要自負法律責任,相關案例層出不窮,請慎重發文!